劃重點

① 被稱為“人工智能教父”的杰弗裡·辛頓博士宣布從谷歌離職,併計劃對他長期推崇的這項技術的風險發出警告。

② 辛頓博士解釋了GPT-4比任何同類模型都更強大的原因,並稱他現在認為數字智能比生物智能更強大,也更危險。

③ 辛頓博士稱,科技巨頭陷入了一場可能無法阻止的競爭。他最擔心的是,互聯網上將充斥著虛假的照片、視頻和文字,普通人將“再也無法辨別真相”。

④ 辛頓博士擔心未來的人工智能技術會對人類生存構成威脅,因為它們經常從分析的大量數據中學習意想不到的行為,真正的自主武器(比如殺人機器人)將會成為現實。

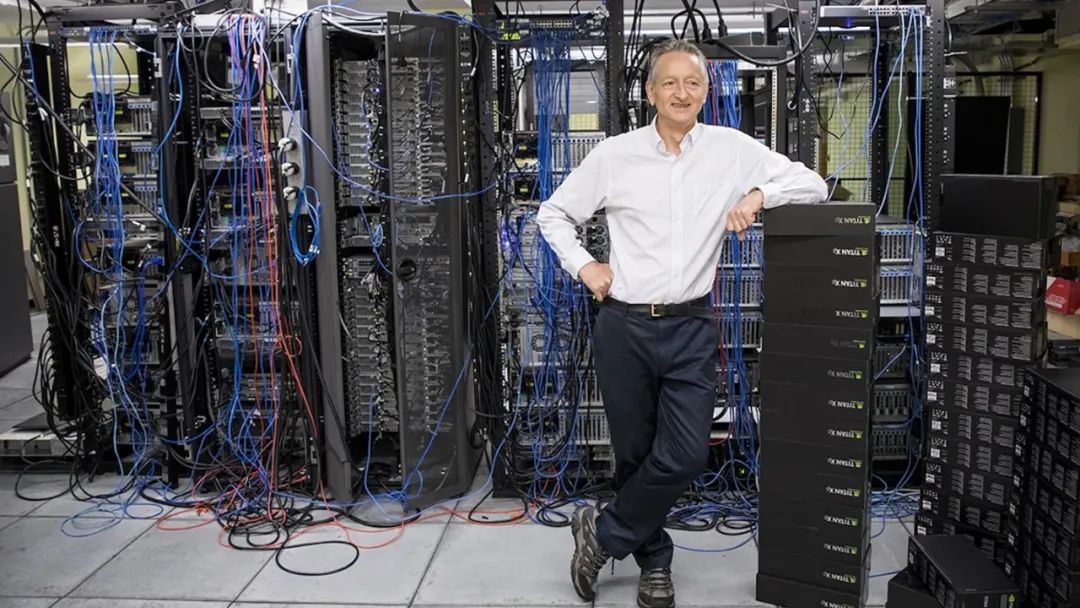

騰訊科技訊5月2日消息,被稱為“人工智能教父”的杰弗裡·辛頓博士(Geoffrey Hinton)宣布從谷歌離職。半個世紀以來,杰弗裡·辛頓幫助開發了ChatGPT等聊天機器人的核心技術。現在,他開始擔心該技術會造成嚴重的傷害。

“就算我不做,別人也會做的”

杰弗裡·辛頓是人工智能領域的先驅。2012年,辛頓博士和他在多倫多大學的兩名研究生開發的技術,成為了人工智能係統的智力基礎。科技行業最大的公司認為,人工智能係統是它們未來的關鍵。

然而,辛頓博士本周正式加入了越來越多的批評人士行列。他們認為,這些公司積極開發基於生成式人工智能(AIGC)的產品,正在走向危險。這種技術為ChatGPT等流行聊天機器人提供動力。

辛頓博士說,他已經辭去了谷歌的工作。他在谷歌工作了十多年,並成為該領域最受尊敬的專家之一,所以他可以從技術層面解讀人工智能的風險。辛頓博士表示,他現在內心有幾分對自己畢生的工作感到後悔。

“我用常用的藉口來安慰自己:就算我不做,別人也會做的,”上週,辛頓博士在多倫多家中的餐廳接受了媒體專訪,那裡距離他和學生取得突破的地方只有幾步之遙。

辛頓博士從人工智能的開拓者向末日預言者的轉變,標誌著科技行業正處於一個不同尋常的時刻,這可能是幾十年來最重要的拐點。行業領袖認為,新的人工智能係統可能與上世紀90年代初推出的網絡瀏覽器一樣重要,可能會在藥物研究和教育等領域帶來突破。

然而,令許多業內人士苦惱的是,他們擔心自己正在釋放一些危險的東西。AIGC已經可以成為製造錯誤信息的工具。很快,這可能會對就業構成威脅。科技行業最大的擔憂者表示,在未來的某個時候,AIGC甚至可能會對人類生存構成威脅。

辛頓博士說:“很難想像如何才能阻止壞人利用它做壞事。”

新一代聊天機器人

舊金山初創公司OpenAI今年3月發布了新版ChatGPT後,1000多名技術領袖和研究人員簽署了一封公開信,呼籲暫停新系統的開發六個月,因為人工智能技術“對社會和人類構成了深刻的風險”。

幾天后,有40年曆史的學術團體人工智能促進協會的19位在任和前任領導人發表了他們自己的公開信,警告人工智能的風險。該組織成員包括微軟首席科學官埃里克·霍維茨,而微軟已將OpenAI的技術應用於一系列產品,包括必應搜索引擎。

常被稱為“人工智能教父”的辛頓博士沒有在這兩封公開信上簽名,他說,在辭職之前,他不想公開批評谷歌或其他公司。上個月,他通知公司自己將辭職,並與穀歌及其母公司Alphabet的首席執行官桑達爾·皮查伊通了電話。他拒絕公開討論與皮查伊談話的細節。

谷歌人工智能業務的首席科學家傑夫·迪恩在一份聲明中表示:“我們仍然致力於以負責任的態度開發和部署人工智能技術。我們在不斷學習理解新出現的風險的同時,也在大膽創新。”

開發神經網絡獲圖靈獎

現年75歲的辛頓博士是英國僑民,他一生從事學術工作,其對人工智能的發展和使用的個人信念推動了整個職業生涯的發展。1972年,作為愛丁堡大學的研究生,辛頓博士接受了名為神經網絡的想法。神經網絡是一種通過分析數據來學習技能的數學系統。當時,很少有研究人員相信這個想法,但這成了他畢生的事業追求。

20世紀80年代,辛頓博士成為卡內基梅隆大學的計算機科學教授,但他離開了這所大學前往加拿大,因為他說自己不願接受美國國防部的資助。當時,美國的大多數人工智能研究都由國防部資助。辛頓博士強烈反對在戰場上使用人工智能,他稱之為“機器人士兵”。

2012年,辛頓博士和他在多倫多的兩名學生伊利亞·蘇斯凱弗和亞歷克斯·克里舍夫斯基建立了一個神經網絡,它可以分析數千張照片,並自學識別常見物體,比如花、狗和汽車等。

谷歌斥資4400萬美元收購了辛頓博士和他的兩個學生創辦的公司。他們的系統催生了越來越強大的技術,包括ChatGPT和谷歌Bard等新型聊天機器人。蘇斯凱弗後來成為OpenAI的首席科學家。2018年,辛頓博士和另外兩位長期合作者因在神經網絡方面的工作獲得了圖靈獎,這一獎項通常被稱為“計算界的諾貝爾獎”。

數字智能更強大

大約在同一時間,谷歌、OpenAI和其他公司開始構建從大量數字文本中學習的神經網絡。辛頓博士認為,這是機器理解和生成語言的一種強大方式,但它仍不如人類處理語言的方式。

去年,隨著谷歌和OpenAI構建了使用大量數據的系統,他的觀點發生了變化。他仍然認為這些系統在某些方面不如人類大腦,但他認為它們在其他方面使人類的智慧黯然失色。辛頓博士說:“也許這些系統中發生的事情實際上比大腦中發生的事情要好得多。”

辛頓博士認為,隨著公司對人工智能係統的改進,它們會變得越來越危險。“看看五年前和現在的情況,”他在談到人工智能技術時說。“它們開似乎接受差異並將其向前傳播,這是非常可怕的。”

辛頓博士表示:“我現在認為,我們正在創造的數字智能與生物智能截然不同。如果我有1000個數字代理,它們都是完全相同權重的克隆體,每當一個代理學習如何做某事時,所有代理都會立即學會,因為它們共享權重。而生物智能做不到這一點。因此,相同的數字代理集合可以獲得比任何單個生物代理多得多的知識。這就是為什麼GPT-4比任何同類模型都更強大的原因。”

辛頓博士在2021年孟買印度理工學院的畢業典禮上說:“我相信人工智能的快速發展將以我們尚未完全理解的方式改變社會,並不是所有的影響都是好的。”他指出,人工智能可能會促進醫學發展,同時也可能被用於創造致命的自主武器。“我發現這種前景比機器人取代人類的前景更直接,也更可怕,我認為機器人取代人類還有很長的路要走。”

人工智能競賽需全球監管

辛頓博士透露,直到去年,谷歌一直是這項技術的“適當管理者” ,小心翼翼地不釋放可能造成傷害的東西。但是現在微軟用聊天機器人增強了必應搜索引擎以挑戰谷歌的核心業務,後者也開始競相部署同樣的技術。

辛頓博士說,科技巨頭陷入了一場可能無法阻止的競爭。他最擔心的是,互聯網上將充斥著虛假的照片、視頻和文字,普通人將“再也無法辨別真相”。

他還擔心人工智能技術最終會顛覆就業市場。如今,像ChatGPT這樣的聊天機器人往往是對人類工作者能力的補充,但它們也可能取代律師助理、個人助理、翻譯和其他從事機械式重複任務的人。他說:“它們承擔了繁重的工作,但帶走的可能不止這些。”

辛頓博士擔心未來的人工智能技術會對人類生存構成威脅,因為它們經常從分析的大量數據中學習意想不到的行為。他說,這成了一個問題,因為個人和公司不僅允許人工智能係統生成自己的計算機代碼,還允許它們自己運行這些代碼。他擔心有一天真正的自主武器(比如殺人機器人)會成為現實。

辛頓博士說:“有些人相信,這類機器實際上會變得比人更聰明。但大多數人認為這太離譜了,我也這麼認為。我曾預計,這需要30年、50年甚至更長的時間。顯然,我現在不再這麼認為了。”

包括他的許多學生和同事在內的許多其他專家表示,這種威脅屬於假想。但辛頓博士認為,谷歌和微軟以及其他公司之間的競爭將升級為一場全球競爭,如果沒有某種全球性監管,這場競賽是不會停止的。

但辛頓博士認為這個問題很難解決。他說,與核武器不同的是,我們沒有辦法知道公司或國家是否在秘密開發這項技術,最大的希望是世界領先的科學家攜手合作。“我認為人們不應該擴大人工智能研發規模,直到他們明白自己是否可以控制它。”

辛頓博士說,當過去人們問他如何才能研發出具有潛在危險的技術時,他會用領導美國製造原子彈的羅伯特·奧本海默的話來解釋:“當你看到某種技術上令人興奮的東西時,你就會去做。”但他現在不再這麼說了。(金鹿)