可能是黃仁勳資訊量最大的採訪

黃仁勳這次史丹佛兩場演講,後一場資訊量賊大,把英偉達基本面最核心的幾個點基本都帶到了,摘出了重點,給大家節省腦帶寬

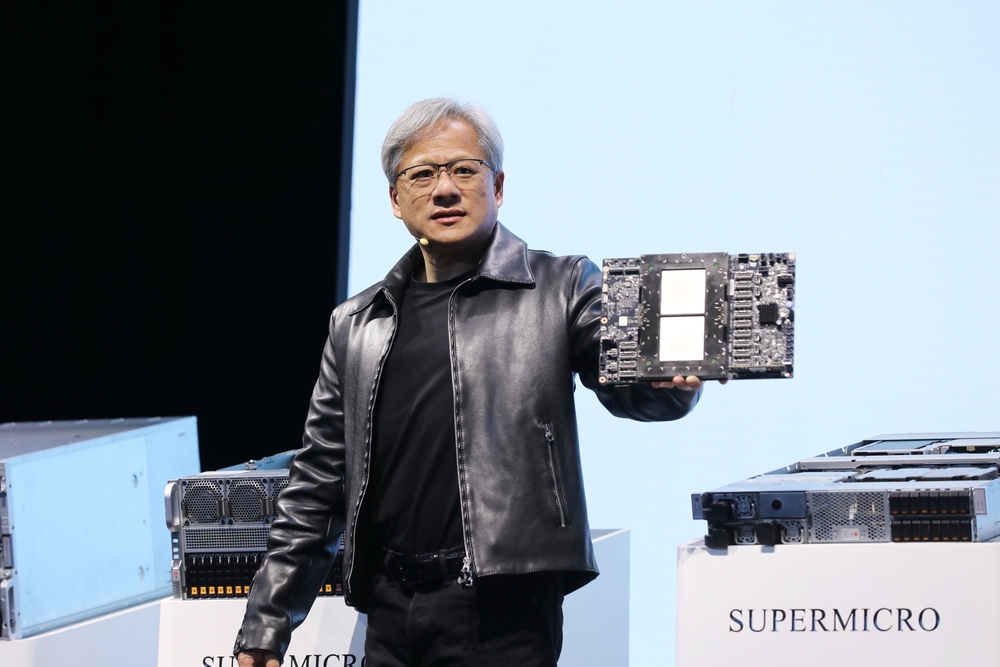

關於加速計算本質

如果我一生中認為最大的技術發展突破,那就是晶體管,但它所實現的最大能力是軟體,是人類以可重複的方式在計算上表達我們的想法和演算法的能力。我們在過去致力於一種新的計算形式,稱為加速計算。通用計算並不適合每個工作領域,所以我們說為什麼不發明一種新的計算方式,解決通用計算不擅長的問題,並且有效地將計算機的計算成本降低到接近零,當你能夠將某物的邊際成本降低到接近零時,我們就能以一種新的方式做軟體,過去是人類編寫,現在電腦編寫,因為計算成本接近零。所以你可以讓電腦去找出代表人類知識的關係和模式。這個奇蹟大約在十年前發生了,我們看到了這一點,推動了這一點,將電腦的邊際成本降低到零。在過去的10年裡,我們將計算成本降低了100萬倍。很多人說,但如果你能將計算成本降低100萬倍,人們花的錢自然會更少,這恰恰相反,我們發現如果我們能將計算的邊際成本降低到接近零,我們可能會用它來做一些非常驚人的事情,需求反而顯著成長。我們販售的H100伺服器是世界上最昂貴的計算機,每片晶片售價2萬多美元,但它所取代的系統的電纜成本就超過了晶片價格。這就是我剛剛解釋的,我們把整個資料中心壓縮成了這片晶片。

關於未來的模型訓練

現在我們訓練模型然後應用模型,再訓練、再推理,在未來,我們將有持續的訓練,甚至我們可以選擇是否把訓練的結果部署到應用中,甚至AI通過觀看視頻和文本,從所有的互動中,不斷地自我改進學習過程和訓練過程。推理過程、訓練過程、部署過程、應用過程將變得一體,這就是我們正在做的。你會發現一直在訓練和推理,這種循環將是持續的。強化學習將基於真實世界數據,這些數據是透過互動以及我們即時創造的合成數據獲得的,電腦會一直在想,這是否有道理?就像當人類學習時,透過資訊片段,然後從第一原則出發,就開始在大腦中進行模擬和想像,那個未來的想像狀態以現實的形式呈現給我們。所以,未來的AI計算機也會做類似的事情,它會合成數據,再進行強化學習,再繼續以真實世界的經驗為基礎,它會想像一些事情,然後用真實世界的經驗來測試,整個循環就是一個巨大的循環。這就是當你能夠將計算成本降低到接近零時,會發生的事情。

(參考我們知識星球中的分析,訓練的需求遠遠被低估...)

關於推理晶片的競爭

今天無論你使用ChatGPT,還是Co-pilot,service now,Mid-Journey,或者Adobe的Firefly,都在進行推理,背後的100%幾乎都是用的NVIDIA的GPU,且大多數輝達被使用的場景也已經變成推理,今天世界上幾乎所有的推理都是NVIDIA。現在大家討論,推理難還是容易?當你看訓練時,你會覺得那看起來太難了,我不會去做,我只是一個晶片公司,但這個系統它看起來根本不像晶片。只是為了證明新東西是否有效,你就要先投入20億美元,然後你啟動了它,發現可能無法運作。你投入了20億美元和兩年時間,就為了證明它不wor k。探索新事物的風險對客戶來說太高了。所以很多競爭對手傾向於說,那我們不做訓練晶片,我們來做推理晶片。那我現在告訴你,推理晶片非常難。你以為,推理的回應時間必須非常快,但這還算簡單的,因為這是電腦科學部分,算是容易的部分。難得部分是,推理的困難在於,部署推理的人的目標,是吸引更多的用戶,將該軟體應用於龐大的安裝用戶基礎。因此,推理是一個關於安裝基礎的問題,這與在iPhone上線APP是一樣的,他們選擇iphone開發APP的原因是iPhone有一個如此龐大的安裝基礎,幾乎每個人都有一部,所以如果你為那部手機編寫了一個應用程序,將受益於它的用戶量,能夠惠及每個人。換成Nvidia的背景板,我們的加速運算平台CUDA是唯一真正無所不在的加速運算平台,因為我們已經在這方面工作了很長時間。如果你為推理編寫了一個應用程序,並且你將模型部署在Nvidia架構上,它可以在任何地方運行,所以你能夠觸及每個人,模型能夠產生更大的影響力。所以推理的問題其實是安裝基礎問題,這需要巨大的耐心和多年的成功、以及對架構相容性的持續貢獻。

關於ASIC的競爭

我們不僅有來自競爭對手的競爭,我們還有來自客戶的競爭(雲廠),而且我是他們眼中唯一的競爭對手。而我們明明知道客戶即將設計一款晶片來取代我們,我還要繼續向他們展示我目前的晶片、下一代的晶片,以及之後的晶片,各種秘密。這樣做的原因是,你要常識讓他們相信你在這個領域是最好,他們才會不得不選擇你。因此,我們都是完全透明的。誠然你可以為特定的演算法建立一款優秀的晶片(ASIC),但記住,計算不僅僅是關於transformer,更何況我們正在不斷地發明新的transformer變種,除此之外,軟體的種類非常豐富,因為軟體工程師喜歡創造新玩意。Nvidia擅長的是加速運算,我們的架構不僅能加速演算法,而且是可編程的,這意味著你可以用它來處理SQL(SQL自20世紀60年代IBM以來就出現了,它是儲存運算中非常重要的部分,每幾年就有300ZB的資料被創造出來,其中大部分都儲存在SQL結構化資料庫中),我們可以加速量子物理學、加速所有的流體和粒子程式碼等等廣泛領域,其中之一才是生成式AI。對於那些希望擁有大量客戶的資料中心來說,無論是金融服務還是製造業等,我們都是最棒的標準。我們存在於每一個雲端服務中,存在於每一個電腦公司。因此,我們公司的架構經過大約30年成為了一種標準。這就是我們的優勢。如果客戶能夠有更具成本效益的替代方案,我甚至會為此感到驚訝。原因是,當你看到現在的電腦時,它不像筆記型電腦,它是一個資料中心,你需要運作它。因此,購買和銷售晶片的人僅僅考慮的是晶片的價格,而營運資料中心的人考慮的是整個營運成本、部署時間、性能、利用率以及在所有這些不同應用中的靈活性。總的來說,我們的總營運成本(TCO)非常好,即使競爭對手的晶片是免費的,最終算下來它也不夠便宜!我們的目標是增加如此多的價值,以至於替代品不僅僅是關於成本的問題。當然,這需要大量的努力,我們必須不斷創新,我們不能對任何事掉以輕心。我本來希望不要聽起來太有競爭性,但約翰問了一個競爭問題,我以為這是個學術論壇....這觸發了我的競爭基因,我道歉,我本可以更藝術地處理這個問題。(哄笑)

什麼時候我們能實現AGI?是50年後還是5年後?

我會給出一個非常具體的答案,但首先讓我告訴你一些正在發生的非常令人興奮的事情。首先,我們正在訓練的這些模型是多模態,這意味著我們將從聲音中學習,從文字中學習,從視覺中學習,就像我們所有人一樣,看電視並從中學習。這很重要,因為我們希望AI不僅僅是基於人類去grounded,當然這是ChatGPT真正創新的地方,也就是RLHF。但直到強化學習,人類將AI都錨定在我們認為好的人類價值上。現在,你能想像,你必須生成圖像和視頻,AI知道手不會穿透講台,踩在水上時你會掉進去,所以現在AI開始錨定在物理上。現在,AI觀看大量不同的例子,例如視頻,來學習這個世界被遵守的規律。它必須創建一個所謂的世界模型。所以,我們必須理解多模態性,還有其他模態,像是基因、胺基酸、蛋白質、細胞等等。

第二點,就是AI會具有更強更強的推理能力,我們人類所做的許多推理,都編碼在常識中。常識是我們所有人類認為理所當然的能力。網路上有很多我們已經編碼好的推理和知識,模型可以學習。但還有更高層次的推理能力,例如現在你問我問題,大部分的問題,我的確像生成式模型一樣快速生成,我不需要太多的reasoning,但有些問題,我需要想想,也就是規劃planning,“很有趣,讓我想想”,我可能是在腦海中循環它,我提出了多個計劃,遍歷我的知識樹tree和graph,修剪我的樹,“這個沒有意義,但這個我可以去做」也就是我會在腦海中模擬模擬運行它,也許我會做一些計算等等。我的意思是,今天的許多“long thinking”,AI並不擅長。你輸入到ChatGPT的一切,它都會立即回應。我們希望輸入到ChatGPT的某個問題,給它一個目標,給它一個使命,它可以思考一會兒。所以,這種系統,電腦科學稱之為系統2,或長思考,或規劃。我認為我們正在研究這些事情,你將會看到一些突破。所以在未來,你與人工智慧的互動方式將會非常不同。有些只是給我一個問題,我會給你答案。有些是說,這裡有個問題,去工作一會兒,明天再告訴我。它會做盡可能多的計算。(註:這種算力需求爆炸了...別算一句話平均多少token了...甚至人均多少token都是沒意義的) 你也可以說,我給你這個問題,你可以花費1000美元,但不要超過這個數額,然後它會在明天給出最好的答案。

所以,回到AGI的問題,AGI的定義是什麼?事實上,這現在是最先需要回答的問題。如果你問我,如果你說Jensen,AGI是一系列測試的列表,記住,尤其工程師最明白,任何組織中,你需要有一個規格,你需要知道產品成功的標準,你需要有一個測試。如果我給你一個AI很多數學測驗、推理測驗、歷史測驗、生物測驗、醫學考試,以及律師考試,甚至包括SAT、MCAT等等,你把這些測驗列出來,擺在電腦科學行業面前,我猜猜在5年內就會在每一個測試上都做得很好。所以,如果你對AGI的定義是通過人類的測試,那麼我會告訴你,五年我們會通過所有的測試。但如果你稍微換一種方式問我,AGI是擁有人類的智能,那麼我不確定如何具體定義人類的所有智能,沒有人真正知道,因此這很難實現,但我們都在努力讓它變得更好。

為了支持AI的成長,需要多少額外的晶片產能?

關於預測,其實我很糟糕,但我非常擅長基於第一原則推演機會的大小。我不知道有多少FAB,但我知道的是,我們今天做的計算,資訊是別人寫的、或是由某人創造的,基本上是預先記錄下來的。我說的是每件事,每個字、語音、視頻,都是檢索式的,有人寫好了它並存儲在某個地方,然後你去檢索它,你知道的每一種模態過去都是這樣。在未來,因為我們的AI可以連接到世界上所有的最新新聞等,也就是可以檢索,它理解你的上下文,意味著它理解你問什麼,關鍵是,大部分的計算將是生成式。今天的100%內容是預先錄製的。如果在未來,100%的內容將是生成式的,問題是這將如何改變計算的形態。所以,這就是我推演這個問題的方式(需要多少晶片),例如我們需要更多的網路嗎?我們需要更多的記憶體嗎?簡單說,我們是需要更多的fab 。然而,我們也在不斷改進演算法和處理過程,效率在時間上有了巨大的提升。並不是說計算的效率就是今天這樣,因此需求就是這麼多。同時,我每10年都在提高運算能力一百萬倍,而需求卻成長一兆倍,這兩者必須相互抵銷。(仔細聽了3遍,的確是這個數量級...算出來太誇張了,可能萬億只是一種形容方式...)然後還有技術擴散等等,這只是時間問題,但這並不改變這樣一個事實:總有一天,世界上所有的電腦都將100%地改變,每一個資料中心,價值數萬億美元的基礎設施,將完全改變,然後在這之上還會建造新的基礎設施。

為什麼輝達開始想做ASIC?

我們是否願意客製化?是的,我們願意。為什麼現在的門檻相對較高?因為我們平台的每一代產品先有GPU,有CPU,有網路處理器,有軟體,還有兩種類型的交換器。我為一代產品建造了五個晶片,人們以為只有GPU一個晶片,但實際上是五個不同的晶片,每個晶片的研發成本都是數億美元,僅僅是為了達到我們所說的“發布”標準,然後你必須將它們整合到一個系統中,然後你還需要網路設備、收發送器、光纖設備,以及大量的軟體。運行一個像這個房間這麼大的計算機,需要大量的軟體,所以這一切都很複雜。如果客製化的需求差異太大,那麼你必須重複整個研發過程。然而,如果客製化能夠利用現有的一切,並在此基礎上增加一些東西,那麼這就非常有意義了。也許是一個專有的安全系統,也許是一個加密計算系統,也許是一個新的數值處理方式,還有更多,我們對這些非常開放。我們的客戶知道我願意做所有這些事情,並且意識到,如果你改變得太多,你基本上就全部重置了,浪費了近千億美元。所以他們希望在我們的生態系統中盡可能地利用這些(減少重置成本)。(這個回答需要仔細揣摩,有更多思考的歡迎知識星球評論區繼續討論)

最後是幾個增量資訊:

Marvel業績會後的callback:公司澄清,預計ASIC在FY4Q25結束時的run rate將遠高於之前說的2億美元/季度,受AI的「顯著」推動,預計全年交付遠高於8億美元。AI專案中有兩個項目很重要,其中一個非常大。交換器和DSP產品推進到3nm,以及更進一步的2nm。營運商和企業市場,預計四月季度將是底部,成長將在下半年更加顯著地恢復。但提到利潤率時又略顯保守,又說企業網路和儲存的反彈情況還有點不確定。預計下一季的光學(DSP等)將年增長強勁。

關於HBM4標準放寬,影響Hybrid Bonding,Barclays的分析:據報道,HBM4的標準已經設定,這可能會推遲混合鍵合技術的採用。我們本週與韓國內存廠商的會議也表明,採用時間比之前預期的要晚,這可能會推遲HB的採用。科技媒體ZDNET Korea(2024年3月8日)通報,JEDEC已經設定了12層和16層HBM4(下一代高頻寬記憶體)的行業標準,與前一代HBM3的720微米相比,HBM封裝的厚度已放寬至775微米。如果屬實,意味著16層HBM目前不需要混合鍵合,可以使用現有的鍵合技術。我們最近舉辦了Besi公司CEO的談話,他說如果封裝高度保持不變,那麼這可能會加速混合鍵合的採用,因為這是在不超出現有高度限制的情況下,從12層增加到16層的唯一方式。但我們本週與亞洲的ODMs、供應鏈和半導體公司進行了交流,根據他們的反饋,HBM4最初將是12層,並使用現有技術,意味著內存廠商將探索所有選項,16層的混合鍵合不是唯一選擇,正在與現有技術一起探索。無論JEDEC規格是否有任何變化,看起來HBM4最初都不會採用Hybrid Bonding。當然,高度厚度只是採用HB的一個原因,另一個好處是增加互連密度,也只能透過HB實現,因此繼續看到HBM在某個時刻轉向HB。在我們看來,Besi管理層最近一直在試圖降低預期,我們預計HBM採用hybrid bonding可能會在2025年底。

某行亞洲供應鏈研究:H100的第四季銷售量約為72萬顆,預計在第一季將增加到約81萬顆,第二季預計提高到約85萬顆。測試產能預計將在第二季/第三季末從每月30萬顆增加到40萬顆,但成長將是漸進的。在下半年,H/B系列的總產能將從每月40萬顆增加到50萬顆。供應鏈尚未獲得B100的初步預測,但指出測試通常需要六個月,且已在第一季開始。ODMs預計B100的實質出貨要到2024年第四季末/2025年第一季初,這比原先預計的第三季來得晚一些。L系列之前預計在第四季度為30萬顆,第一季為60萬顆,現在預計每月約為10萬顆,並且在下半年隨著NVDA尋找向CN銷售的方法,可能會更加穩健。ODMs談到了AMD約50萬顆的銷量,而NVDA為400萬顆,代表AMD在2024年的單位份額為11%。這個數字乍看之下似乎有些過於樂觀,但ODMs越來越多地談到了AMD預計在今年下半年推出的新設計。( 資訊平權 )