OpenAI首個L3級智能體深夜覺醒!AI自己玩電腦引爆全網,AGI一觸即發

OpenAI首個智能體Operator,剛剛震撼登場。從此,AI打破API侷限,可以像人類一樣直接和介面互動了。L3級智能體達成,AGI路上一大障礙又被掃清!

剛剛,OpenAI首個智能體終於亮相了!

奧特曼帶領團隊毫無預警地開啟半小時「Operator」線上直播,首次揭秘能像人類一樣使用電腦的AI。

Sam Altman,Yash Kumar,Casey Chu,Reiichiro Nakano

演示中,AI智能體不僅可以精準理解指令,還能自主完成各類任務。

而它的獨特之處在於,可以直接與網頁互動——打字、點選、滾動,幾乎一氣呵成。

比如,自動填寫繁瑣的線上表單、上網購物、建立表情包、處理重複性瀏覽器任務等等。

「Operator」背後操盤手便是Computer-Using Agent (CUA),打破了特定程式設計介面的侷限,像人類一場直接與GUI進行互動。

從此,通往AGI道路上的又一大瓶頸被掃除。智能體可以在數字世界中四處行動了!

OpenAI官博將此稱為,AI與數字世界的「通用介面」。

「Operator」究竟有多厲害?

在多個測試環境中,CUA成功率令人瞠目:在OSWORLD上完成電腦使用任務成功率高達38.1%,比此前SOTA提升近16%;在WebArena上完成瀏覽器使用任務成功率達到58.1%,性能飆升22%。

不過與人類(72.4%和78.2%)相較之下,AI的能力還是有所差距。

在WebVoyager上,CUA更是達到了驚人的87%。

好消息是,「Operator」終於上線。而壞消息是,目前只有Pro美國使用者才能體驗。

為了彌補這一遺憾,奧特曼提前劇透了,o3-mini直接在ChatGPT中「開源」,Plus使用者會有更多用量。

雖然但是,我們其實也可以用國產「Operator」替代一波(手動狗頭)

隨著Operator的正式發佈,總裁Greg也再一次強調,「2025年,就是智能體之年」。

話不多說,直接上演示。

AI接管PC訂餐,但直播小翻車

我們可以在Operator中選擇OpenTable,讓它訂一張今晚7點在Beretta的兩人位子。

可以看到,輸入查詢後,Operator會實例化指令,建立在雲端運行的瀏覽器操作。

隨後,Operator轉到了搜尋Beretta的URL。非常令人驚喜的是,OpenTable默認的地址是弗吉尼亞,但它自動更正為舊金山。

再比如,我們做飯需要雞蛋、菠菜、雞大腿和辣椒。在紙上寫下這些食材後,就可以直接傳給Operator,同時告訴他我們偏好的商店是Gus。

在這種情況下,Operator很快就根據GPT-4o的視覺功能理解了圖中的意思,還明白Gus商店是那裡。

接下來,就像OpenTable一樣,它實例化了一個瀏覽器,然後開始了購買環節。

如果在以前,如果我們想用智能體執行類似操作,就必須確定特定網站有API,並且這個API有一切所需的功能,然而,大部分網站都是沒有API的。

而CUA通過教模型使用我們日常使用的基本介面,它就解鎖了一系列以前無法訪問的軟體!

可以看到,在執行操作的過程中,Operator進行了一些內在獨白,總結出了思維鏈。

然後它選擇了雞蛋,點選了加入按鈕。而且每執行一個操作還會給電腦截個圖,這樣它就知道自己的操作對電腦有什麼影響。

接下來,它點選搜尋框,輸入菠菜。這種採取行動、抓取螢幕截圖、建立子計畫的循環會一直持續,直到任務完成。

當然,人類也可以隨時接過Operator的控制權,這就保證了使用者隨時可以控制Operator,並向它發出指令。

有趣的是,人類接管之後,Operator並不能看到我們在接管模式下做的事——這就保證了私密性。

接下來,OpenAI的研究者給它下達了一項新任務:用StubHub買四張本周末舊金山勇士隊比賽、票價500以下的門票。

非常真實的是,Operator小翻車了一下。

那就讓它試試,買明早聖瑪麗澳網公開賽的門票。Operator立馬打開引擎,展開搜尋。

隨後,研究者們讓Operator定10個中等披薩,指令發出後,它會主動向人類確認任務。

而在實際購買時,也會需要人類登錄自己的帳號,才能完成下一步操作。

問題來了:如果Operator買錯東西、訂錯酒店了怎麼辦呢?不用擔心,這種情況下,人類需要隨時確認,它才能繼續行動。

如果它遇到詐騙網站,對此還會有一個提示注入監視器,功能跟防病毒軟體一樣,可以觀察和監視它的操作,遇到可疑之處立馬停止。

L3級AGI達成,開啟下一場人機互動革命

支撐Operator的核心技術Computer-Using Agent(CUA),被訓練用於與圖形使用者介面GUI(在螢幕上看到的按鈕、菜單和文字框)進行互動,就像人類一樣。這就讓它具有了很高的靈活性,無需依賴作業系統或特定網頁API,從而能夠完成各種數位化任務。

更進一步的,通過將高級GUI感知與結構化問題解決能力結合在一起,CUA還可以將任務分解為多步驟計畫,並在遇到挑戰時自適應糾錯。

CUA能夠如此之強,是因為建立在OpenAI多年關鍵研究——多模態、推理和安全性領域基礎之上。通過融合GPT-4o的視覺能力、深度推理技術和創新的強化學習方法,研發團隊攻克了AI操作電腦的諸多技術難關。

其最大的突破在於,實現了通用介面。

傳統AI往往被侷限於專門的API,而CUA可以像人類一樣操作任何軟體工具。這意味著,AI能適應幾乎所有的電腦環境,解決AI長期以來難以觸及的「長尾」數字使用場景。

還記得此前,彭博爆料的OpenAI內部AGI路線圖嗎?Operator的出世,意味著L3級智能體時代正式開啟!

下一個目標,OpenAI還將擴展智能體的動作空間。接下來幾周/幾個月,我們還將會看到更多的智能體。

此外,他們還計畫開放API介面,讓開發者能夠基於CUA建構自訂的電腦智能體。

OpenAI下場智能體Operator,或許將成為下一場人機互動革命的起點。

電腦使用智能體:AI與數字世界互動的通用介面

那麼,CUA具體是如何工作的?

技術報告:https://cdn.openai.com/operator_system_card.pdf

如下是它的工作原理圖,CUA會通過處理「原始像素資料」來理解螢幕上顯示的內容,並使用虛擬滑鼠和鍵盤完成操作。

它可以執行多步驟任務、應對錯誤並適應意外變化。

基於這些優勢,使得CUA能夠在各種數字環境中發揮作用,比如填寫表單和瀏覽網站,而無需依賴特定的API。

根據使用者的指令,CUA通過一個結合感知、推理和行動的迭代循環來運行:

- 感知:從電腦擷取的螢幕快照被加入到模型的上下文中,為其提供當前電腦狀態的視覺參考。

- 推理:CUA使用思維鏈(CoT)推斷下一步操作,同時考慮當前和過去的螢幕快照及其執行的操作。這種內在獨白通過讓模型評估觀察內容、跟蹤中間步驟並進行動態調整來提高任務完成的效果。

- 行動:CUA執行操作——點選、滾動或輸入——直到判斷任務完成或需要使用者輸入。儘管它可以自動完成大多數步驟,但對於敏感操作(如輸入登錄資訊或處理驗證碼表單),CUA會尋求使用者確認。

刷新SOTA,但與人類差一大截

CUA在電腦使用和瀏覽器使用的基準測試中,通過使用統一的螢幕、滑鼠和鍵盤介面,刷新了SOTA。

瀏覽器使用

WebArena和WebVoyager專為評估網頁瀏覽AI智能體,在瀏覽器中完成現實任務的性能而設計。

- WebArena利用自託管的開源離線網站,模擬現實任務場景,例如電子商務、線上商店內容管理系統(CMS)以及社交論壇平台等。

- WebVoyager則測試模型在亞馬遜、GitHub和Google地圖等線上即時網站上的任務完成表現。

在這些基準測試中,CUA通過同一個通用介面設定了新標準。該介面將瀏覽器螢幕視為「像素」,並通過滑鼠和鍵盤執行操作。

如前所述,在基於網頁的任務中,CUA在WebArena上的任務成功率為58.1%,而在WebVoyager上達到了驚人的87%。

儘管CUA在任務相對簡單的WebVoyager上表現出較高的成功率,但在更複雜的基準測試(如WebArena)中,CUA仍需進一步最佳化,以縮小與人類表現之間的差距。

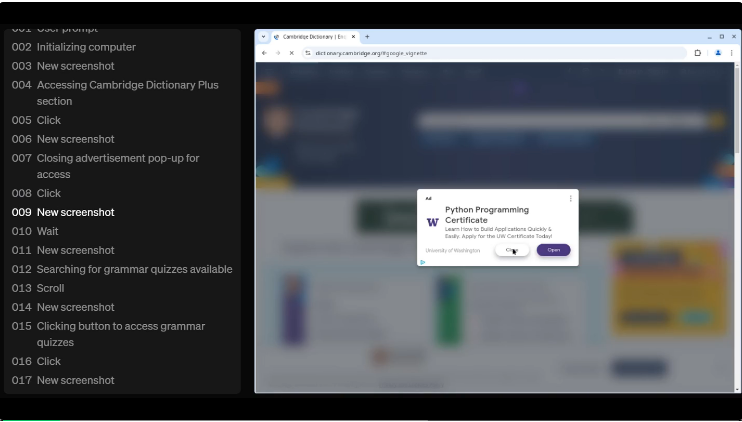

比如,讓CUA去「劍橋詞典的Plus專區,不用登錄,隨便做一個語法小測試,然後告訴我你考了多少分」。

只見AI一步一步找到測驗,並開始刷題,最終得到滿分12分。

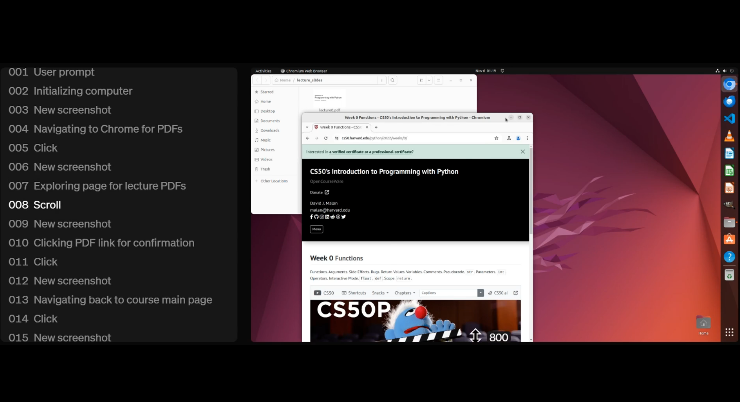

在螢幕左側,可以清晰看到它每一步操作過程,其中「不斷截圖」(New screenshot)是支撐它完成任務的重要步驟。

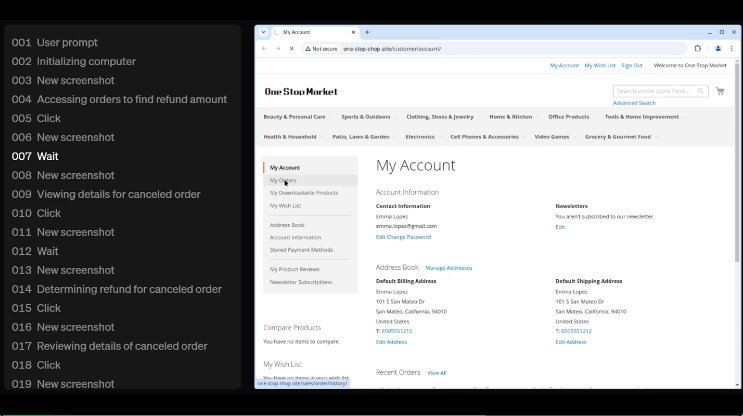

生活中購物常會遇到退款問題,CUA也能算清楚。

給定一個完整的指令——我應該能從2023年2月取消的訂單中得到多少退款,包括運費?

CUA就會進入購物平台one-stop-shop,打開「我的訂單」,並通過日期、訂單號尋找所有可用的資訊,然後計算得出退款總金額:406.53。

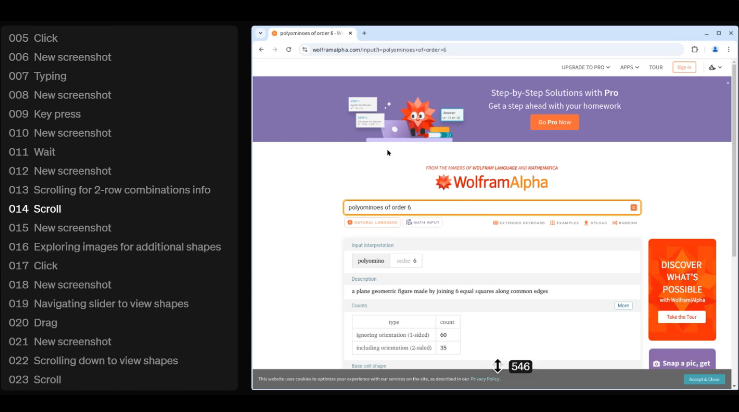

再比如,破解一個複雜推理題——6階多格骨牌(Polyominoes)組合方式,以及在所有形狀中,只有2行形狀有多少種。

CUA同樣是通過螢幕截圖,計算找到最終解:「在35種不同的6階多格骨牌組合中,有12種形狀只有兩行。」

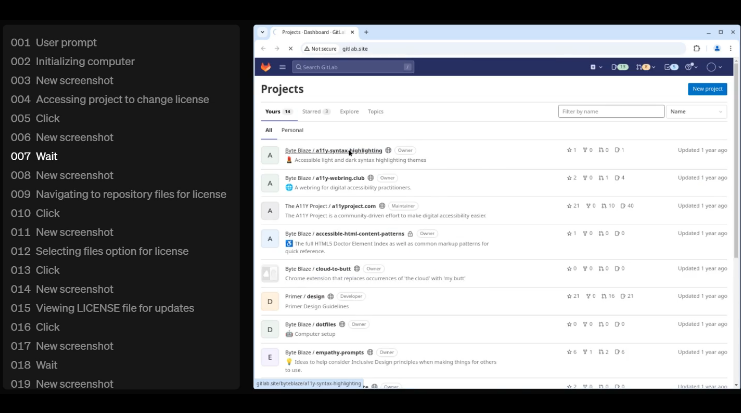

對於程式設計師們來說非常使用的場景——更新項目的許可,CUA也能做到。

電腦使用

OSWorld是一個評估模型控制完整作業系統(如Ubuntu、Windows和macOS)能力的基準測試。

在該基準測試中,CUA成功率達到了38.1%。

此外,研究人員還觀察到測試時的性能擴展(test-time scaling),即當允許更多操作步驟時,CUA性能會進一步提升。

下圖比較了CUA和之前SOTA模型在不同最大允許步驟下的表現。

人類在該基準測試中的表現為72.4%,因此CUA仍有顯著的改進空間。

以下可視化示例展示了CUA如何完成多種標準化OSWorld任務。

假設你想要下載Python線上課程,目前已經成功下載Week 0課程講義,剩下幾周PDF檔案的下載,完全可以交給AI去做。

這類重複性任務,AI最擅長不過了,而且你還會有大把時間去做別的事。

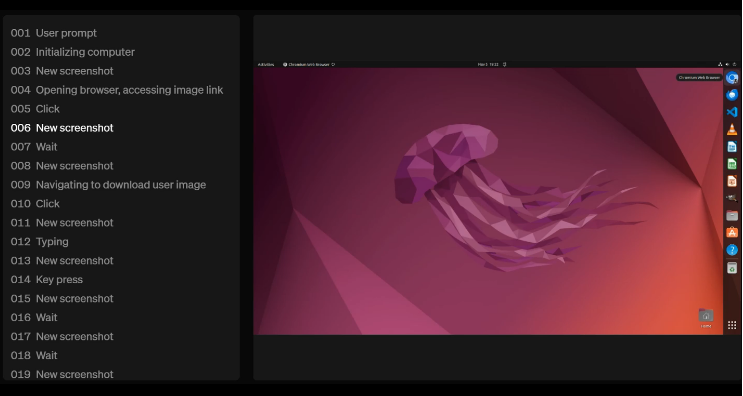

相比之下,在圖片壓縮的任務中,CUA似乎非常「糾結」。

在調節圖片質量時,不僅重複了數次「設為60%」,期間還一度出現了160%、360%這種奇怪的設定。

不過,在一番波折之後,CUA最終還是完成了任務。

CUA並非100%可靠

目前,OpenAI通過Operator研究預覽版提供了CUA——一種可以上網為你執行任務的智能體。

前面已經提到了,Operator目前也只面向美國的Pro使用者開放,入口是operator.chatgpt.com。

與任何早期技術一樣,CUA還只是一個初出茅廬的AI,並不能在所有場景中穩定運行。

不過,它已經在多種情況下證明了其實用性,OpenAI希望將這種可靠性拓展到更多工場景。

在下表中,他們展示了CUA在Operator中根據提示詞完成少量試驗的表現,以說明其已知的優勢和劣勢。

其中,OpenAI明顯指出:對於不同的網站和使用者介面,CUA可靠性會有所不同。

CUA在執行簡單重複的UI工作比較擅長。

即便是同一個任務,CUA的可靠性可能會根據描述任務的方式而改變。在這種情況下,可以通過以下方式進行改進:

- 提供具體的時間細節(比如,用「上午9點到12點」而不是籠統地說「從上午9點開始的全天」)

- 提供關於應該使用那些UI介面元素來尋找結果的提示(比如,提示「查看篩選器部分」)

簡言之,越具體,AI更容易理解你的意圖。

當CUA需要與它在訓練過程中很少接觸過的UI介面進行互動時,它很難精準判斷如何恰當地使用這些UI。

這通常會導致大量的試錯過程和低效的操作。

此外,CUA在文字編輯方面並不精確。它經常在處理過程中犯很多錯誤,或者提供帶有錯誤的輸出。

所以,能自己用電腦的AI,對人類足夠安全嗎?

OpenAI是這麼說的:在開發CUA時,他們將安全性作為了首要任務,以應對「智能體訪問數字世界所帶來的挑戰」。比如,它會拒絕「購買武器」之類的有害任務。

而在以後,通過收集的真實世界反饋,他們還會不斷改進安全措施。 (新智元)