大語言模型簡史:從Transformer(2017)到DeepSeek-R1(2025)的進化之路

2025年初,中國推出了具有開創性且高性價比的「大型語言模型」(Large Language Model — LLM)DeepSeek-R1,引發了AI的巨大變革。本文回顧了LLM的發展歷程,起點是2017年革命性的Transformer架構,該架構通過「自注意力機制」(Self-Attention)徹底重塑了自然語言處理。到2018年,BERT和GPT等模型嶄露頭角,顯著提升了上下文理解和文字生成能力。2020年,擁有1750億參數的GPT-3展示了卓越的「少樣本」和「零樣本」學習能力。然而,「幻覺」問題 — —即生成內容與事實不符,甚至出現「一本正經地胡說八道」的現象 — — 成為了一個關鍵挑戰。2022年,OpenAI通過開發「對話式」的ChatGPT應對這一問題,採用了「監督微調」(SFT)和「基於人類反饋的強化學習」(RLHF)。到2023年,像GPT-4這樣的「多模態模型」整合了文字、圖像和音訊處理能力,使LLM能夠以更接近人類的「聽」、「說」、「看」能力。

近期推出的OpenAI-o1和DeepSeek-R1「推理模型」(Reasoning Model)在複雜問題解決方面取得突破,賦予LLM更接近人類「系統2思維」的深度推理能力,標誌著人工智慧在模擬人類思維模式上邁出了重要一步。此外,DeepSeek-R1模型以其「超成本效益」和「開源」設計挑戰了AI領域的傳統規範,推動了先進LLL的普及,並促進了各行業的創新。

1. 什麼是語言模型 (Language Models)?

「語言模型」是一種「人工智慧系統」,旨在處理、理解和生成類似人類的語言。它們從大型資料集中學習模式和結構,使得能夠產生連貫且上下文相關的文字,應用於翻譯、摘要、聊天機器人和內容生成等領域。

1.1 大型語言模型(LLMs)

「語言模型」(LMs)和「大型語言模型」(LLMs)這兩個術語雖然經常被互換使用,但實際上它們基於規模、架構、訓練資料和能力指代不同的概念。LLMs 是 LMs 的一個子集,其規模顯著更大,通常包含數十億個參數(例如,GPT-3 擁有 1750 億個參數)。這種更大的規模使 LLMs 能夠在廣泛的任務中表現出卓越的性能。

“LLM”這一術語在 2018 至 2019 年間隨著基於 Transformer 架構的模型(如 BERT 和 GPT-1)的出現開始受到關注。然而,在 2020 年 GPT-3 發佈後,這個詞才被廣泛使用,展示了這些大規模模型的重大影響力和強大能力。

1.2 自回歸語言模型 (Autoregressive Language Models)

大多數LLMs以「自回歸方式」(Autoregressive)操作,這意味著它們根據前面的「文字」預測下一個「字」(或token/sub-word)的「機率分佈」(propability distribution)。這種自回歸特性使模型能夠學習複雜的語言模式和依賴關係,從而善於「文字生成」。

在數學上,LLM 是一個機率模型(Probabilistic Model),根據之前的輸入文字(₁₂ₙ₋₁)預測下一個字ₙ 的機率分佈。這可以表示為:

ₙ₁₂ₙ₋₁

在文字生成任時,LLM通過解碼演算法(Decoding Algorithm)來確定下一個輸出的字。這一過程可以採用不同的策略:既可以選擇機率最高的下個字(即貪婪搜尋),也可以從預測的機率分佈中隨機採樣一個字。後一種方法使得每次生成的文字都可能有所不同,這種特性與人類語言的多樣性和隨機性頗為相似。

1.3 生成能力

LLMs的自回歸特性使其能夠基於前文提供的上下文逐詞生成文字。從「提示」(prompt)開始,如下圖,模型通過迭代預測下一個詞,直到生成完整的序列或達到預定的停止條件。為了生成對提示的完整回答,LLM通過將先前選擇的標記加入到輸入中進行迭代生成,猶如「文字接龍」遊戲。

LLM的文字生成猶如「文字接龍」遊戲。

這種生成能力推動了多種應用的發展,例如創意寫作、對話式人工智慧以及自動化客戶支援系統。

2. Transformer革命 (2017)

Vaswani等人在2017年通過其開創性論文“Attention is All You Need”引入了Transformer架構,標誌著NLP的一個分水嶺時刻。它解決了早期模型如循環神經網路(RNNs)和長短期記憶網路(LSTMs)的關鍵限制,這些模型在長程依賴性和順序處理方面存在困難。這些問題使得使用RNN或LSTM實現有效的語言模型變得困難,因為它們計算效率低下且容易出現梯度消失等問題。另一方面,Transformers克服了這些障礙,徹底改變了這一領域,並為現代大型語言模型奠定了基礎。

自注意力和Transformer架構

2.1 Transformer架構的關鍵創新

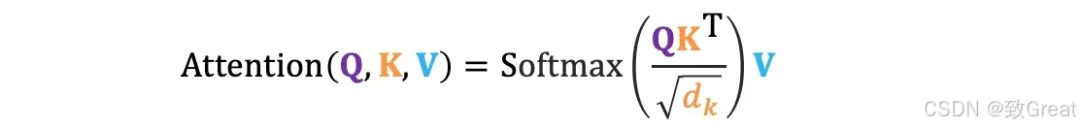

- 自注意力機制 (Self-Attention):與按順序處理標記並難以應對長程依賴性的RNN不同,Transformers使用自注意力來權衡每個標記相對於其他標記的重要性。這使得模型能夠動態關注輸入的相關部分。數學上:

這裡,Q、K、V是查詢(query)、鍵(key)和值(value)矩陣,dₖ是鍵的維度。自注意力允許平行計算,加快訓練速度,同時提高全域上下文理解。

- 多頭注意力:多個注意力頭平行操作,每個頭專注於輸入的不同方面。它們的輸出被連接並轉換,從而實現更豐富的上下文表示。

- 前饋網路(FFN)和層歸一化(Layer Norm):每個Transformer層包括應用於每個標記的前饋網路,以及層歸一化和殘差連接。這些穩定了訓練並支援更深的架構。

- 位置編碼:由於Transformers本身不編碼標記順序,因此加入了位置編碼(位置和頻率的正弦函數)以表示詞序,在不犧牲平行化的情況下保留順序資訊。

2.2 對語言建模的影響

- 可擴展性:Transformers實現了完全平行化的計算,使得在大型資料集上訓練大規模模型成為可能。

- 上下文理解:自注意力捕捉局部和全域依賴關係,提高了連貫性和上下文意識。

Transformer架構的引入為建構能夠以前所未有的精確性和靈活性處理複雜任務的大規模高效語言模型奠定了基礎。

3. 預訓練Transformer模型時代 (2018–2020)

2017年Transformer架構的引入為NLP的新時代鋪平了道路,其特點是預訓練模型的興起和對擴展的前所未有的關注。這一時期見證了兩個有影響力的模型家族的出現:BERT和GPT,它們展示了大規模預訓練和微調範式的強大功能。

3.1 BERT:雙向上下文理解 (2018)

2018年,Google推出了BERT(Bidirectional Encoder Representations from Transformers),這是一種使用Transformer編碼器(Encoder)的突破性模型,在廣泛的NLP任務中取得了最先進的性能。與之前單向處理文字(從左到右或從右到左)的模型不同,BERT採用了雙向訓練方法,使其能夠同時從兩個方向捕獲上下文。通過生成深層次的、上下文豐富的文字表示,BERT在文字分類、命名實體識別(NER)、情感分析等語言理解任務中表現出色。

BERT的關鍵創新包括:

- 掩碼語言建模(Masker Language Modeling — MLM):BERT不是預測序列中的下一個詞,而是被訓練預測句子中隨機掩碼的標記。這迫使模型在進行預測時考慮整個句子的上下文 — — 包括前後詞語。例如,給定句子“The cat sat on the [MASK] mat”,BERT會學習根據周圍上下文預測“soft”。

- 下一句預測(Next Sentence Prediction — NSP):除了MLM之外,BERT還接受了稱為下一句預測的次要任務訓練,其中模型學習預測兩個句子是否在文件中連續。這幫助BERT在需要理解句子之間關係的任務中表現出色,例如問答和自然語言推理。

BERT的影響:BERT的雙向訓練使其在GLUE(通用語言理解評估)和SQuAD(斯坦福問答資料集)等基準測試中取得了突破性的表現。它的成功證明了上下文嵌入的重要性 — — 這些表示根據周圍詞語動態變化 — — 並為新一代預訓練模型鋪平了道路。

3.2 GPT:生成式預訓練和自回歸文字生成(2018–2020)

雖然BERT優先考慮雙向上下文理解,但OpenAI的GPT系列採用了不同的策略,專注於通過自回歸預訓練實現生成能力。通過利用Transformer的解碼器(Decoder),GPT模型在自回歸語言模型和文字生成方面表現出色。

GPT (2018)GPT的第一個版本於2018年發佈,是一個大規模的Transformer模型,經過訓練以預測序列中的下一個詞,類似於傳統語言模型。

- 單向自回歸訓練:GPT使用因果語言建模目標進行訓練,其中模型僅基於前面的標記預測下一個標記。這使得它特別適合於生成任務,如文字補全、摘要生成和對話生成。

- 下游任務的微調:GPT的一個關鍵貢獻是它能夠在不需要特定任務架構的情況下針對特定下游任務進行微調。只需加入一個分類頭或修改輸入格式,GPT就可以適應諸如情感分析、機器翻譯和問答等任務。

GPT-2 (2019)在原版GPT的成功基礎上,OpenAI發佈了GPT-2,這是一個參數量達15億的更大模型。GPT-2展示了令人印象深刻的零樣本(Zero-shot)能力,意味著它可以在沒有任何特定任務微調的情況下執行任務。例如,它可以生成連貫的文章、回答問題,甚至在語言之間翻譯文字,儘管沒有明確針對這些任務進行訓練。

GPT-3 (2020)GPT-3的發佈標誌著語言模型規模擴展的一個轉折點。憑藉驚人的1750億參數(175B parameters),GPT-3突破了大規模預訓練的可能性界限。它展示了顯著的少樣本(Few-short)和零樣本(Zero-short)學習能力,在推理時只需提供最少或無需示例即可執行任務。GPT-3的生成能力擴展到了創意寫作、程式設計和複雜推理任務,展示了超大模型的潛力。

3.3 GPT的影響及規模的作用

GPT模型的引入,特別是GPT-3,標誌著AI的一個變革時代,展示了自回歸架構和生成能力的強大功能。這些模型為內容創作、對話代理和自動推理等應用開闢了新的可能性,在廣泛的任務中達到了接近人類的表現。GPT-3憑藉其1750億參數證明了規模的深遠影響,表明在大規模資料集上訓練的更大模型可以樹立新的AI能力標竿。

語言建模性能隨著模型大小、資料集大小和訓練使用的計算量的增加而平穩提升。https://arxiv.org/pdf/2001.08361

在2018年至2020年間,該領域由對規模的不懈追求驅動。研究人員發現,隨著模型規模的增長 — — 從數百萬到數十億參數 — — 它們在捕捉複雜模式和泛化到新任務方面變得更好。這種規模效應得到了三個關鍵因素的支援:

- 資料集大小:更大的模型需要龐大的資料集進行預訓練。例如,GPT-3是在大量網際網路文字語料庫上進行訓練的,使其能夠學習多樣化的語言模式和知識領域。

- 計算資源:強大的硬體(如GPU和TPU)的可用性以及分佈式訓練技術,使得高效訓練具有數十億參數的模型成為可能。

- 高效架構:混合精度訓練和梯度檢查點等創新降低了計算成本,使得在合理的時間和預算內進行大規模訓練更加實際。

這個規模擴展的時代不僅提升了語言模型的性能,還為未來的AI突破奠定了基礎,強調了規模、資料和計算在實現最先進結果中的重要性。

4. 後訓練對齊:彌合AI與人類價值觀之間的差距 (2021–2022)

GPT-3(一個擁有1750億參數的LLM)生成幾乎無法與人類寫作區分的文字的能力引發了關於AI生成內容的真實性和可信度的重大擔憂。儘管這一成就標誌著AI發展的一個重要里程碑,但也突顯了確保這些模型與人類價值觀、偏好和期望保持一致的關鍵挑戰。一個主要問題是「幻覺」(Hallucination),即LLM生成與事實不符、無意義或與輸入提示矛盾的內容,給人一種「一本正經地胡說八道」的印象。為瞭解決這些挑戰,2021年和2022年的研究人員專注於改善與人類意圖的一致性並減少幻覺,導致了監督微調(SFT)和基於人類反饋的強化學習(RLHF)等技術的發展。

4.1 監督微調 (SFT)

增強GPT-3對齊能力的第一步是監督微調(SFT),這是RLHF框架的基礎組成部分。SFT類似於指令調優,涉及在高品質的輸入-輸出對或演示上訓練模型,以教它如何遵循指令並生成所需的輸出。

這些演示經過精心策劃,以反映預期的行為和結果,確保模型學會生成精準且符合上下文的響應。

然而,SFT本身有侷限性:

- 可擴展性:收集人類演示是勞動密集型且耗時的,尤其是對於複雜或小眾任務。

- 性能:簡單模仿人類行為並不能保證模型會超越人類表現或在未見過的任務上很好地泛化。

為了克服這些挑戰,需要一種更具可擴展性和效率的方法,為下一步鋪平了道路:基於人類反饋的強化學習(Reinforcement Learning from Human Feedback — RLHF)。

4.2 基於人類反饋的強化學習 (RLHF)

OpenAI在2022年引入的RLHF解決了SFT的可擴展性和性能限制。與需要人類編寫完整輸出的SFT不同,RLHF涉及根據質量對多個模型生成的輸出進行排名。這種方法允許更高效的資料收集和標註,顯著增強了可擴展性。

RLHF過程包括兩個關鍵階段:

- 訓練獎勵模型:人類註釋者對模型生成的多個輸出進行排名,建立一個偏好資料集。這些資料用於訓練一個獎勵模型,該模型學習根據人類反饋評估輸出的質量。

- 使用強化學習微調LLM:獎勵模型使用近端策略最佳化(Proximal Policy Optimization - PPO)(一種強化學習演算法)指導LLM的微調。通過迭代更新,模型學會了生成更符合人類偏好和期望的輸出。

這個兩階段過程 — — 結合SFT和RLHF — — 使模型不僅能夠準確遵循指令,還能適應新任務並持續改進。通過將人類反饋整合到訓練循環中,RLHF顯著增強了模型生成可靠、符合人類輸出的能力,為AI對齊和性能設定了新標準。

4.3 ChatGPT:推進對話式AI (2022)

2022年3月,OpenAI推出了GPT-3.5,這是GPT-3的升級版,架構相同但訓練和微調有所改進。關鍵增強包括通過改進資料更好地遵循指令,減少了幻覺(儘管未完全消除),以及更多樣化、更新的資料集,以生成更相關、上下文感知的響應。

ChatGPT基於GPT-3.5和InstructGPT,OpenAI於2022年11月推出了ChatGPT,這是一種突破性的對話式AI模型,專門為自然的多輪對話進行了微調。ChatGPT的關鍵改進包括:

- 對話聚焦的微調:在大量對話資料集上進行訓練,ChatGPT擅長維持對話的上下文和連貫性,實現更引人入勝和類似人類的互動。

- RLHF:通過整合RLHF,ChatGPT學會了生成不僅有用而且誠實和無害的響應。人類培訓師根據質量對響應進行排名,使模型能夠逐步改進其表現。

ChatGPT的推出標誌著AI的一個關鍵時刻,通常被稱為「ChatGPT時刻」(ChatGPT moment),因為它展示了對話式AI改變人機互動的潛力。

5. 多模態模型:連接文字、圖像及其他 (2023–2024)

在2023年至2024年間,像GPT-4V和GPT-4o這樣的多模態大型語言模型(MLLMs)通過將文字、圖像、音訊和視訊整合到統一系統中重新定義了AI。這些模型擴展了傳統語言模型的能力,實現了更豐富的互動和更複雜的問題解決。

5.1 GPT-4V:視覺遇見語言

2023年,OpenAI推出了GPT-4V,將GPT-4的語言能力與先進的電腦視覺相結合。它可以解釋圖像、生成標題、回答視覺問題,並推斷視覺中的上下文關係。其跨模態注意力機制允許文字和圖像資料的無縫整合,使其在醫療保健(如分析醫學圖像)和教育(如互動學習工具)等領域具有價值。

5.2 GPT-4o:全模態前沿

到2024年初,GPT-4o通過整合音訊和視訊輸入進一步推進了多模態。它在一個統一的表示空間中運行,可以轉錄音訊、描述視訊或將文字合成音訊。即時互動和增強的創造力 — — 如生成多媒體內容 — — 使其成為娛樂和設計等行業的多功能工具。

現實世界的影響: MLLMs革新了醫療保健(診斷)、教育(互動學習)和創意產業(多媒體製作)等領域。它們處理多種模態的能力解鎖了創新的新可能性。

6. 開源和開放權重模型 (2023–2024)

在2023年至2024年間,開源和開放權重AI模型獲得了動力,使先進AI技術的訪問民主化。

- 開放權重LLMs:開放權重模型提供公開訪問的模型權重,限制極少。這使得微調和適應成為可能,但架構和訓練資料保持封閉。它們適合快速部署。例子:Meta AI的LLaMA系列和Mistral AI的Mistral 7B / Mixtral 8x7B

- 開源LLMs:開源模型使底層程式碼和結構公開可用。這允許全面理解、修改和定製模型,促進創新和適應性。例子:OPT和BERT。

- 社區驅動的創新:像Hugging Face這樣的平台促進了協作,LoRA和PEFT等工具使高效的微調成為可能。

社區開發了專門針對醫療、法律和創意領域的模型,同時優先考慮道德AI實踐。 開源社區目前處於一個激動人心的階段,得益於尖端對齊技術的出現。這一進展導致越來越多的卓越開放權重模型發佈。因此,閉源和開放權重模型之間的差距正在穩步縮小。LLaMA3.1–405B模型首次歷史性地彌合了與閉源對應物的差距。

7. 推理模型:從「系統1」到「系統2」思維的轉變 (2024)

2024年,AI開發開始強調增強「推理」(Reasoning),從簡單的模式識別轉向更邏輯化和結構化的思維過程。這一轉變受到認知心理學雙重過程理論的影響,區分了「系統1」(快速、直覺)和「系統2」(緩慢、分析)思維。雖然像GPT-3和GPT-4這樣的早期模型在生成文字等「系統1」任務上表現出色,但在深度推理和問題解決方面卻有所欠缺。

「系統1」與「系統2」思維

7.1 OpenAI-o1:推理能力的一大飛躍(2024)

OpenAI於2024年12月發佈的o1模型旨在提高AI的推理能力,特別是在程式碼生成和偵錯等複雜任務上表現出色。o1模型的一個關鍵特徵是通過「思維鏈」(Chain of Thought-CoT)過程增強推理能力,使其能夠將複雜問題分解為更小、更易管理的步驟。

推理時間計算與能力

- 思維鏈:o1模型在提供答案之前花費額外時間「思考」(thinking),通過生成思維鏈來增強複雜推理,特別是在科學和數學領域。模型的精準性與在回答前用於思考的計算量的對數相關。

- :o1模型套件包括o1、o1-mini和o1 pro。o1-mini比o1-preview更快且更具成本效益,適用於程式設計和STEM相關任務,儘管它缺乏o1-preview的廣泛世界知識。

- 性能:o1-preview在物理、化學和生物學的基準測試中達到了大約博士水平的表現。在美國數學邀請賽中,它解決了83%的問題,相比之下GPT-4o解決了13%。它還在Codeforces程式設計競賽中排名在第89百分位。

OpenAI-o1的發佈標誌著AI開發的一個關鍵時刻,展示了結合生成和推理能力創造能夠像人類一樣思考和行動的模型的潛力。隨著該領域的不斷髮展,推理模型有望解鎖AI的新前沿,使機器能夠應對人類面臨的最具挑戰性的問題。

8. 成本高效的推理模型:DeepSeek-R1 (2025)

LLMs通常需要極其龐大的計算資源來進行訓練和推理。像GPT-4o和OpenAI-o1這樣的最先進LLM模型的閉源性質限制了對尖端AI的「普及化」。

8.1 DeepSeek-V3 (2024–12)

2024年12月下旬,「深度求索-V3」(DeepSeek-V3)作為一種成本高效的開放權重LLM出現,為AI的可訪問性設定了新標準。DeepSeek-V3與OpenAI的ChatGPT等頂級解決方案相媲美,但開發成本顯著降低,估計約為560萬美元,僅為西方公司投資的一小部分。該模型最多包含6710億個參數,其中370億個活躍參數,並採用專家混合(MoE)架構,將模型劃分為專門處理數學和編碼等任務的元件,以減輕訓練負擔。DeepSeek-V3採用了工程效率,例如改進Key-Value快取管理和進一步推動專家混合方法。該模型引入了三個關鍵架構:

- 多頭潛在注意力(Multi-head Latent Attention — MLA):通過壓縮注意力鍵和值來減少記憶體使用,同時保持性能,並通過旋轉位置嵌入(RoPE)增強位置資訊。

- DeepSeek專家混合(DeepSeekMoE):在前饋網路(FFNs)中採用共享和路由專家的混合,以提高效率並平衡專家利用率。

- 多標記預測 (Multi-Token Prediction — MTP):增強模型生成連貫且上下文相關的輸出的能力,特別是對於需要複雜序列生成的任務。

DeepSeek-V3的發佈引發了全球科技拋售,危及1兆美元的市值,並導致輝達股票盤前下跌13%。DeepSeek-V3的價格為每百萬輸出標記2.19美元,約為OpenAI類似模型成本的1/30。

8.2 DeepSeek-R1-Zero 和 DeepSeek-R1 (2025–01)

僅僅一個月後,2025年1月下旬,DeepSeek通過發佈DeepSeek-R1-Zero和DeepSeek-R1再次引起轟動,這些模型展示了卓越的推理能力,訓練成本極低。利用先進的強化學習技術,這些模型證明了高性能推理可以在沒有通常與尖端AI相關的巨額計算費用的情況下實現。這一突破鞏固了DeepSeek作為高效和可擴展AI創新領導者的地位。

- DeepSeek-R1-Zero:一種基於DeepSeek-V3的推理模型,通過強化學習(RL)增強其推理能力。它完全消除了「監督微調」(SFT)階段,直接從名為DeepSeek-V3-Base的預訓練模型開始。它採用了一種基於「規則的強化學習方法」(Rule-based Reinforcement Learning),稱為「組相對策略最佳化」(Group Relative Policy Optimization — GRPO),根據預定義規則計算獎勵,使訓練過程更簡單且更具可擴展性。

- DeepSeek-R1:為瞭解決DeepSeek-R1-Zero的侷限性,如低可讀性和語言混雜,DeepSeek-R1納入了一組有限的高品質冷啟動資料和額外的RL訓練。該模型經歷了多個微調和RL階段,包括拒絕採樣和第二輪RL訓練,以提高其通用能力和與人類偏好的一致性。

- 蒸餾DeepSeek模型:DeepSeek開發了較小的、蒸餾版的DeepSeek-R1,參數範圍從15億到700億,將先進的推理能力帶到較弱的硬體上。這些模型使用原始DeepSeek-R1生成的合成資料進行微調,確保在推理任務中表現出色,同時足夠輕量化以便本地部署。

DeepSeek 蒸餾DeepSeek模型

DeepSeek-R1在各種基準測試中表現出競爭力,包括數學、編碼、常識和寫作。根據使用模式,它相比OpenAI的o1模型等競爭對手提供了顯著的成本節省,使用成本便宜20到50倍。

8.3 對AI行業的影響

DeepSeek-R1的引入挑戰了AI領域的既定規範,使先進LLMs得以「普及化」,並促進了一個更具競爭力的生態系統。其可負擔性和可訪問性預計將推動各行各業的採用和創新增加。最近,領先的雲服務提供商如AWS、微軟和Google雲已在其平台上提供DeepSeek-R1。較小的雲提供商和DeepSeek母公司以競爭性定價提供它。

結論

從2017年Transformer架構的引入到2025年DeepSeek-R1的發展,大型語言模型(LLMs)的演變標誌著人工智慧領域的一個革命性篇章。LLMs的崛起由四個里程碑式的成就標示:

- Transformers (2017):Transformer架構的引入為建構能夠以前所未有的精確性和靈活性處理複雜任務的大規模高效模型奠定了基礎。

- GPT-3 (2020):該模型展示了規模在AI中的變革力量,證明了在大規模資料集上訓練的巨大模型可以在廣泛的應用中實現接近人類的表現,為AI所能完成的任務設立了新的基準。

- ChatGPT (2022):通過將對話式AI帶入主流,ChatGPT使高級AI對普通使用者來說更加可訪問和互動。它還引發了關於廣泛採用AI的倫理和社會影響的關鍵討論。

- DeepSeek-R1 (2025):代表了成本效率的一大飛躍,DeepSeek-R1利用專家混合架構(MoE)和最佳化演算法,與許多美國模型相比,營運成本降低了多達50倍。其開源性質加速尖端AI應用的普及化,賦予各行業創新者權力,並強調了可擴展性、對齊性和可訪問性在塑造AI未來中的重要性 (ChallengeHub)