•

輝達突然開源新模型!性能直逼 DeepSeek-R1,4 倍推理吞吐量卷翻天

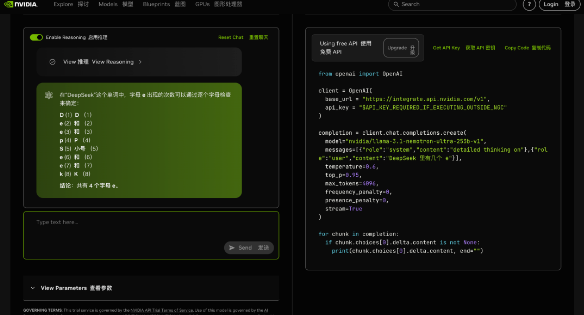

今天,輝達開源了一款名為 Llama-3.1-Nemotron-Ultra-253B-v1 的新模型。

該模型基於 Meta 早期的 Llama-3.1-405B-Instruct 模型開發,擁有 2530 億個參數,在多項第三方基準測試中表現出色。

🥊 輝達新模型的性能逼近擁有 6710 億參數的 DeepSeek R1,但只用了不到一半的參數量。

測試結果顯示,GPQA(76 vs. 71.5)、IFEval 指令遵循(89.5 vs. 88.8)和 LiveCodeBench 編碼任務(66.3 vs. 65.9)。

並且,Llama-3.1-Nemotron-Ultra-253B 推理吞吐量也比 DeepSeek R1 671B 高 4 倍。

不過,在 MATH500 和 Arena Hard 基準測試中,DeepSeek R1 仍略佔優勢。

據悉,Llama-3.1-Nemotron-Ultra-253B 的設計目標是支援高級推理、指令遵循以及 AI 助手工作流程。

技術特點如下:

1️⃣ 採用神經架構搜尋(NAS)最佳化架構

2️⃣ 引入跳躍注意力層、融合前饋網路(FFN)和可變 FFN 壓縮率

3️⃣ 降低記憶體佔用和計算需求,保持輸出質量

4️⃣ 可在單個 8x H100 GPU 節點高效部署

5️⃣ 部署支援 B100 和 Hopper 微架構硬體

6️⃣ 在 BF16 和 FP8 精度模式下均驗證通過

目前,該模型的程式碼已在 Hugging Face 平台上公開,包含開放的權重和訓練後資料。

🤖 Llama-3.1-Nemotron-Ultra-253B 可用於聊天機器人開發、AI Agent 工作流、檢索增強生成(RAG)和程式碼生成等場景。根據輝達開放模型許可證及 Llama 3.1 社區許可協議,該模型已獲准用於商業用途。