【CES 2026】再細說說引爆儲存類股的邊際變化(附資訊源)

輝達黃仁勳在CES 2026大會發佈的AI計算平台Vera Rubin對全球儲存器產業鏈——NAND Flash、SSD、HBM和LPDDR產生了全面而深遠的影響

(具體資訊源已全部附在文末)

AI基礎設施進入全新時代

2026年1月5日,NVIDIA CEO黃仁勳在CES 2026大會上宣佈Vera Rubin平台正式推出。該平台由六款新晶片組成,包括Rubin GPU、Vera CPU、NVLink 6交換機、ConnectX-9 SuperNIC、BlueField-4資料處理單元和Spectrum-6乙太網路交換機[1]。

他說:物理AI的ChatGPT時刻已經到來,機器開始理解、推理並在現實世界中行動。[2]

根據IDC分析,這不僅僅是周期性短缺,而是全球矽晶圓產能的永久性戰略重新分配。數十年來,DRAM和NAND Flash的生產主要服務於智慧型手機和PC,但如今這一格局已經逆轉。

微軟、Google、Meta和亞馬遜等超大規模雲服務商對HBM的旺盛需求,迫使三大儲存器製造商(三星電子、SK海力士和美光科技)將有限的潔淨室空間和資本支出轉向利潤率更高的企業級元件[3]。

Vera Rubin平台核心規格一覽:

對NAND Flash與SSD產業的影響

企業級SSD需求爆發式增長

NVIDIA在CES 2026上發佈的Inference Context Memory Storage Platform(推理上下文記憶體儲存平台)將NVMe SSD推向AI基礎設施的核心位置。這一平台將GPU的KV快取擴展到基於NVMe的儲存中,旨在解決大型語言模型推理過程中KV快取容量受限的問題[5]。

黃仁勳在演講中強調:"AI正在革新整個計算堆疊——現在輪到儲存了。AI不再是一次性的聊天機器人,而是理解物理世界、進行長期推理、基於事實、使用工具完成實際工作並保留短期和長期記憶的智能協作者。"[5]

該平台核心優勢:

- 比傳統儲存高達5倍的每秒token處理能力

- 5倍的性能功耗比

- 5倍的性能成本比

- 首次token響應時間改善20倍

合作夥伴包括AIC、Cloudian、DDN、Dell Technologies、HPE、Hitachi Vantara、IBM、Nutanix、Pure Storage、Supermicro、VAST Data和WEKA[5]。

NAND Flash價格持續攀升

NVIDIA的AI平台需求正在導致NAND Flash供需結構性失衡。

根據TrendForce最新預測:

- 2026年Q1 NAND Flash合約價格

預計環比上漲33-38% - 客戶端SSD價格漲幅最高

預計超過40%,為所有NAND Flash產品中漲幅最大 - 企業級SSD

將在2026年成為NAND Flash最大的應用細分市場[6]

IDC預測,2026年DRAM和NAND供應增長將低於歷史正常水平,分別僅為16%和17%同比增長。這是一場零和博弈:每一片分配給NVIDIA GPU HBM堆疊的晶圓,就是一片被拒絕用於中端智慧型手機LPDDR5X模組或消費級筆記型電腦SSD的晶圓[3]。

SSD廠商戰略調整

在CES 2026上,KIOXIA展示了其針對AI最佳化的儲存解決方案,展示了其SSD如何利用公司參與開發的開放原始碼軟體來最佳化和加速AI應用程式和工作負載。KIOXIA還推出了採用第8代BiCS FLASH 3D快閃記憶體的BG7系列NVMe SSD[7]。

SanDisk在CES期間推出了"SanDisk Optimus"品牌的內建NVMe固態硬碟產品線重組,其中最高端的"GX PRO"系列面向建構AI PC和工作站的開發者、專業人士和遊戲玩家[8]。

Western Digital股價在NVIDIA CES儲存演講後飆升17%,反映出市場對AI驅動儲存需求的樂觀預期[8]

HBM4時代正式開啟

NVIDIA Vera Rubin平台的發佈標誌著HBM4時代正式到來。Rubin GPU是首款整合HBM4記憶體的產品,每顆GPU配備最高288GB的HBM4記憶體,頻寬高達22 TB/s。值得注意的是,NVIDIA最初在去年預告Rubin時目標僅為13 TB/s的HBM4頻寬,22 TB/s的躍升完全通過矽片實現,不依賴記憶體壓縮等技術[9]。

HBM頻寬代際演進:

HBM供應商競爭格局重塑

NVIDIA對HBM4的巨大需求正在重塑儲存器供應商的競爭格局:

SK海力士:在2026年新年致詞中指出,HBM3E將在今年繼續主導市場,預計佔HBM總出貨量的約三分之二,而HBM4將逐步增加份額。SK海力士在CES 2026期間首次展示了16層48GB HBM4產品,速度達到業界最快的11.7Gbps[11][12]。

三星電子:計畫在2026年底將HBM產能提升至每月約25萬片晶圓,比目前的17萬片增長約47%。三星和SK海力士已開始向NVIDIA交付付費的HBM4最終樣品,從免費原型階段進入預合同、商業化驅動的供應階段[13][14]。

市場份額(2025年Q3):

- SK海力士:53%

- 三星電子:35%

- 美光科技:11%[15]

HBM價格持續走強

由於AI需求持續旺盛,HBM及相關儲存器價格維持高位:

- 三星和SK海力士將2026年HBM3E供應價格上調近20%[16]

- 伺服器DRAM價格上調60-70%,Google、微軟等已在排隊採購[17]

- 美國銀行估計2026年HBM市場將達到546億美元,同比增長58%[18]

- 高盛預測,面向定製ASIC AI晶片的HBM需求將飆升82%,佔市場的三分之一[18]

摩根士丹利分析師預計三星的儲存器利潤將在2026年增長310%,接近100兆韓元利潤大關[19]。

16層HBM4開發加速

NVIDIA的需求正在推動更先進HBM技術的開發。根據電子時報報導,NVIDIA要求韓國和海外儲存器製造商在2026年第四季度交付16層HBM記憶體晶片。SK海力士、三星電子和美光都已開始全面開發工作[20]。

16層HBM堆疊極為複雜,現有12層HBM的晶圓厚度約為50微米,而16層HBM需要將厚度減少到約30微米才能堆疊16層[20]。

LPDDR產業的“地震級”影響

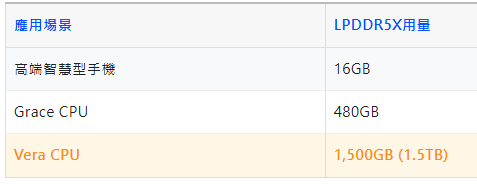

LPDDR5X需求結構性轉變

NVIDIA向LPDDR記憶體的轉型正在對整個消費電子供應鏈產生"地震級"影響。Vera CPU將配備最高1.5TB的LPDDR5X記憶體(是Grace的3倍),使用NVIDIA與美光聯合開發的SOCAMM模組。整個Vera Rubin NVL72機架將配備54TB的LPDDR5X容量[4]。

Counterpoint Research分析師指出:"更大的風險在於先進記憶體領域,因為NVIDIA最近轉向LPDDR意味著它成為了一個規模相當於主要智慧型手機製造商的客戶——這對供應鏈來說是一個地震般的轉變,無法輕易吸收這種規模的需求。"[21]

LPDDR5X需求對比:

消費電子面臨壓力

由於NVIDIA的巨量需求,消費電子產品將面臨儲存器供應緊張和價格上漲的雙重壓力:

- DDR5 64GB RDIMM價格可能在2026年底翻倍

- 智慧型手機記憶體價格預計在未來兩個季度內從當前水平上漲50%

- 中端智慧型手機的記憶體成本可能佔物料清單(BOM)的15-20%[21][3]

IDC警告稱,由於記憶體價格飆升,2026年PC市場可能萎縮高達9%[21]

SOCAMM2標準崛起

NVIDIA的Vera Rubin平台推動了SOCAMM2這一新型記憶體模組標準的普及:

- 三星電子已開始提供SOCAMM2客戶樣品

- SOCAMM使用堆疊的LPDDR5X晶片,為AI伺服器提供更高頻寬和更低功耗

- 相比DDR5 RDIMM具有兩倍的頻寬和更低的功耗

- 被定位為AI伺服器中銲接記憶體的標準化、可維護替代方案[22][23]

新韓投資預測,2025年LPDDR需求將溫和增長,但2026年隨著AI伺服器越來越多地採用節能記憶體解決方案,將出現急劇擴張[22]。

各細分市場影響總結:

參考文獻

[1] NVIDIA Newsroom. "NVIDIA Kicks Off the Next Generation of AI With Rubin."

[2] Axios. "Nvidia CES 2026: Jensen Huang says 'ChatGPT moment for physical AI' is coming."

[3] IDC. "Global Memory Shortage Crisis: Market Analysis and the Potential Impact on the Smartphone and PC Markets in 2026."

[4] Tom's Hardware. "Nvidia launches Vera Rubin NVL72 AI supercomputer at CES."

[5] Blocks & Files. "Nvidia pushes AI inference context out to NVMe SSDs."

[6] TrendForce. "Memory Makers Prioritize Server Applications, Driving Across-the-Board Price Increases in 1Q26."

[7] TweakTown. "KIOXIA showcases memory and SSD solutions for AI, mobile, and data centers at CES 2026."

[8] TechStock². "Western Digital (WDC) stock jumps 17% after Nvidia CES storage talk sparks AI-driven rally."

[9] The Register. "Nvidia unpacks Vera Rubin rack system at CES."

[10] The Next Platform. "Nvidia's Vera-Rubin Platform Obsoletes Current AI Iron Six Months Ahead Of Launch."

[11] TrendForce. "SK hynix 2026 Outlook: HBM3E Dominates, HBM4 Dual Strategy Amid 3 Market Headwinds."

[12] WCCFTech. "SK hynix Delivers Next-Gen Memory Solutions: 48 GB HBM4 at 11.7 Gbps Speeds."

[13] TrendForce. "Samsung Reportedly Plans 50% HBM Capacity Surge in 2026."

[14] TrendForce. "SK hynix, Samsung Reportedly Deliver Paid HBM4 Samples to NVIDIA."

[15] Yahoo Finance. "Samsung Electronics says customers praised competitiveness of HBM4 chip."

[16] TrendForce. "Samsung, SK hynix Reportedly Plan ~20% HBM3E Price Hike for 2026."

[17] TrendForce. "Samsung, SK Reportedly Hike Server DRAM Prices 60-70%."

[18] SK hynix Newsroom. "2026 Market Outlook: SK hynix's HBM to Fuel AI Memory Boom."

[19] Investing.com. "Samsung stock soars after plans to mass produce HBM4 for Nvidia AI chips."

[20] TweakTown. "SK hynix, Samsung, and Micron fighting for NVIDIA supply contracts for new 16-Hi HBM4 orders."

[21] Tom's Hardware. "Server memory prices to double year-over-year in 2026, LPDDR5X prices could follow."

[22] The Korea Herald. "Samsung takes early lead in next-gen AI server memory with Nvidia."

[23] Tom's Hardware. "Samsung introduces SOCAMM2 LPDDR5X memory module for AI data centers." (FinHub)