全球社群媒體大轉型

最近,裁員的風吹到了矽谷。

當地時間11月9日,社群媒體臉書(Facebook)母公司Meta首席執行官馬克·祖克柏確認了整體裁員的規模,裁員人數約為員工總數的13%,總數達到11000人。

其實在此次動蕩之前,一場全球社群媒體大轉型運動,早已經拉開序幕。

這場轉型運動的核心關乎平台內容治理,始自2018年。悉數這一年的代表性事件,“劍橋分析”無法避開。

2018年3月,Facebook承認,英國數據分析公司劍橋分析在2016年美國總統大選前違規獲得五千萬用戶信息。而後Facebook因未能妥善保護用戶個人敏感信息等被集體訴訟,同時,美國聯邦貿易(FTC)也對Facebook展開調查。而馬克·扎克伯克本人,也因劍橋分析事件出席美參議院委員會聽證會,接受議員問詢。無論“劍橋分析”是不是導火索,但從2018年起,治理內容生態,就開始成為大部分社群媒體的核心工作。社群媒體上的有害內容一般包括不實信息、仇恨言論和兒童色情等。在這場轉型運動中,Facebook、Instagram等社群媒體,增設了多種功能以提升內容治理能力、對抗有害內容。這既是平台承擔社會責任的體現,某種程度上,也是對監管力量和輿論質疑的回應。本期全媒派(ID:quanmeipai)分享一篇來自波動刻度的文章,和大家一起來看看,海外社群媒體巨頭們在平台內容治理方面存在著怎樣的難度?以及他們是從哪些方面進行轉型的?

對抗不實消息

除了傳統的憑空捏造或以訛傳訛的虛假信息(misinformation),如今社群媒體上還湧現出大量的誤導性信息(disinformation)。這類不實信息往往基於政治或商業目的,摻雜某些真實的信息,從而實現更強的迷惑性,無論是平台算法,還是普通用戶,都更難鑑別。作為應對,全球最大的社群媒體Facebook自2016年發起事實核查計劃,至今已與全球範圍內的80多家獨立第三方核查機構合作。

每當事實核查機構將平台上的一條內容評定為“虛假”時,Facebook會大幅減少該內容的傳播,以降低其曝光率。2021年5月,Facebook進一步推出系列措施以治理不實信息。此前,當事實核查機構認為某條帖子是不實信息後,轉發過的用戶將會收到提醒,Facebook優化了這一機制。

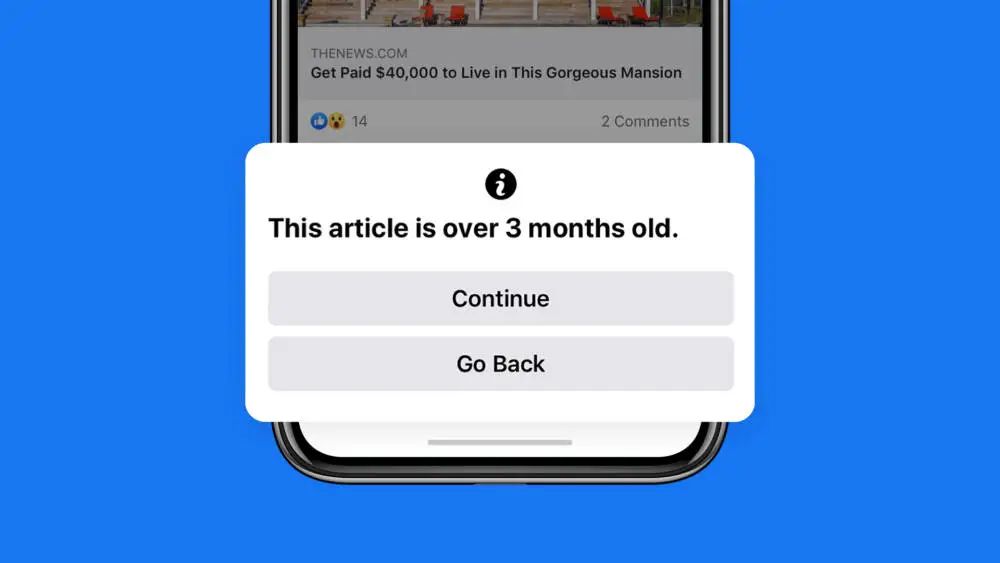

如今,用戶可以查看事實核查機構評估該信息失實的理由,已經轉發的不實信息也會被加上標籤,提醒其他用戶這是不實信息。Facebook還會警告用戶,如果多次散播不實信息,他們的帖子將會更少地出現在其他用戶的信息流中。許多用戶在Facebook上獲取新聞資訊並進行討論,但有一些用戶會重新分享過去的新聞信息或帖子,並將其作為新的信息,而這可能會傳播錯誤信息,或者讓人對新近發生的事實產生誤解。針對這一問題,Facebook增設了一個警告的彈窗,當用戶想要分享的內容的發佈時間超過90天時,就會收到提醒。

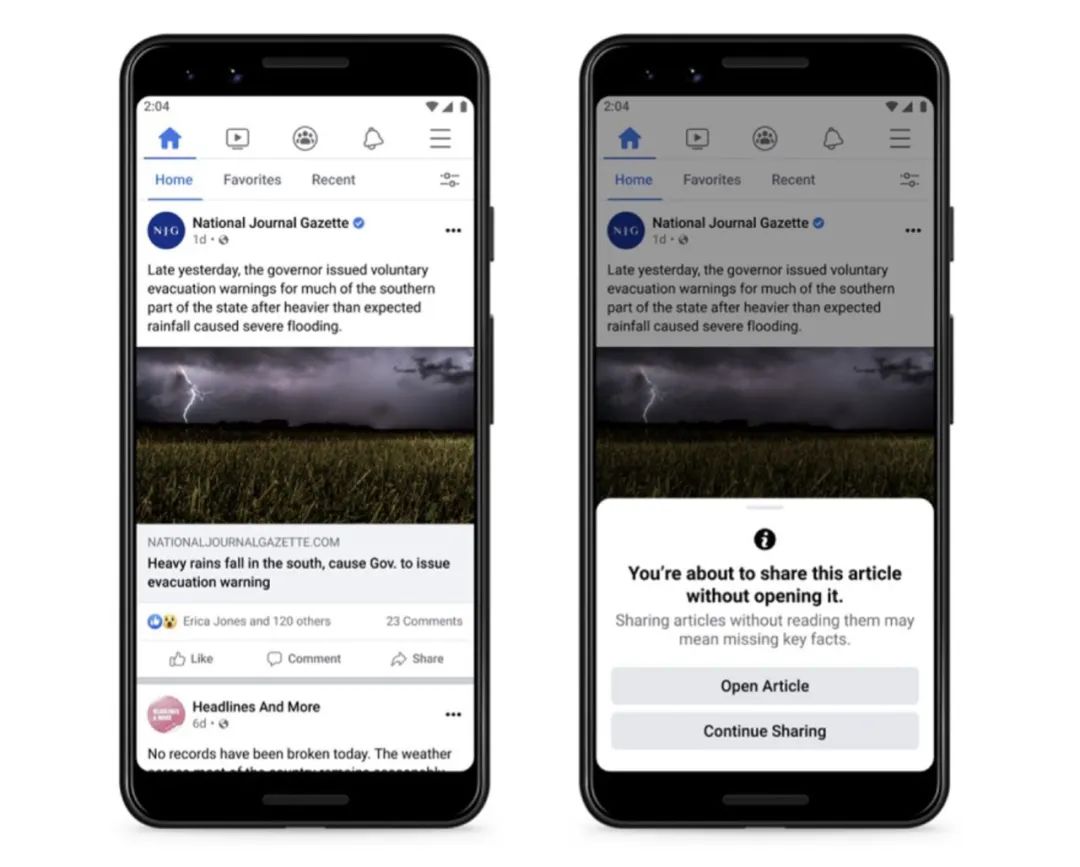

此外,有許多用戶往往並沒有閱讀文章內容,而是在看到某個文章的標題後就轉發。這可能散播不實信息,並且僅僅依據標題就與他人展開討論,可能沒有什麼意義。為了讓用戶更加負責任地轉發信息,Facebook會提醒那些沒點開鏈接就按下“轉發”按鈕的用戶:你將要分享你沒有閱讀的文章,這可能意味著在關鍵事實上犯錯。

實際上,早在2020年6月,Twitter就在其安卓客戶端試行了這一功能。Twitter產品總監Kayvon Beykpour表示[1]:

“在Twitter上,鏈接或者文章很容易被瘋轉,這可能產生強大的影響,但有時這是危險的,特別是當用戶沒有閱讀他們所傳播的內容時。這項功能鼓勵用戶在轉發之前點擊鏈接並閱讀文章。

”試行三個月後,Twitter表示,用戶在看到提示後打開文章的次數增加了40%,在轉發前打開文章的次數增加了33%。有些用戶在打開文章後最終沒有轉發,說明閱讀文章的確能讓用戶更謹慎地決定要不要轉發。

疫情背景下,社群媒體上湧現了大量與疫情相關的不實信息,造成惡劣影響,比如宣稱接種疫苗會得癌症的“反疫苗運動”。早在2020年2月,世界衛生組織在新冠肺炎疫情報告中就特別提到,疫情的暴發會引發一場大規模的“信息流行病(Information epidemic)”,即在一些事實中混入恐懼、猜測和流言,這些不實信息可能會在世界範圍內迅速傳播,影響全球經濟、政治與安全。

Facebook也針對疫情相關的不實信息推出了治理措施。在用戶準備分享疫情相關鏈接時,將會跳出一個通知,這一通知會展示相關內容的發佈時間和來源,並附有Facebook的“COVID-19信息中心”鏈接,讓用戶能夠更方便地獲取權威的關於疫情的可靠信息。不過,用戶在轉發政府衛生部門和全球衛生組織(如世界衛生組織)發布的內容時將不會出現這個通知,以避免減緩可信的衛生部門的信息傳播速度。此外,Facebook的算法系統將會刪除被醫療專家標記為失實的疫情相關信息,從疫情暴發到2021年4月,Facebook就刪除超過1200萬條和新冠疫情或疫苗相關的不實信息。

治理仇恨言論

除了虛假信息,如何治理仇恨言論,也是社群媒體平檯面臨的一個棘手問題。根據Meta(Facebook於2021年改名為Meta,旗下包括Facebook和Instagram等產品)的定義,仇恨言論包括暴力或非人性(dehumanizing)的言論、低劣的聲明、呼籲基於某些特徵而排斥他人,這些特徵包括種族、宗教信仰、性取向、性別和疾病等。[3]Instagram在2021年增設了一系列功能以治理仇恨言論。

其中有一個功能被命名為“limits”,當用戶啟用後,系統會自動隱藏來自不關注你的人,或最近才關注你的人的評論和私信請求。

根據Instagram的說法,開發這個功能是因為創作者和公眾人物會收到大量來自他們不認識的人的評論和私信,其中可能含有大量的垃圾或謾罵信息。但是許多用戶又不想完全關閉評論和私信功能,仍然希望與粉絲互動聯繫,因此可以限制那些不是粉絲或最近才成為粉絲的人發布評論和私信。

當有用戶試圖發表攻擊性評論時,Instagram也會顯示警告提醒:如果他們堅持發布,他們的評論可能會被刪除或者隱藏。Instagram發現這些警告的確能夠阻止用戶發布攻擊性言論。根據統計,在一周的時間內,Instagram平均每天顯示約一百萬次警告,在大約50%的時間裡,用戶根據這些警告重新編輯或刪除了評論。

網絡暴力行為的產生,多是由於情緒驅動的“一時之快”,儘管一個警告提示並不能真正阻止用戶發布惡意言論,但它讓發表評論多了一個步驟,減少了因衝動而言語攻擊他人的可能。

此外,Instagram還推出了一個叫“Hidden Words”的功能,開啟這一功能後,系統可以自動過濾攻擊性詞語和emoji,並將其收集到隱藏文件夾中,用戶可以自己選擇是否要查看這一文件夾。

這一功能也可以幫助用戶過濾那些可能是垃圾郵件或低質量的私信請求。Instagram表示,將持續更新擴大自動過濾的攻擊性言論、主題標籤(hashtag)和emoji的清單。

內容治理的難度

內容治理已經成為全球共識,無論是各國政府、公眾抑或是社群媒體本身,都認為有必要處理平台上的假新聞和仇恨言論等有害信息。

但是,處理有害信息之前,首先需要確定哪些信息屬於有害信息。這並非易事,有時還存在巨大爭議。

例如,諷刺性的信息和攻擊謾罵的區別是什麼?名人轉發假新聞和普通人轉發假新聞是否需要區別對待?這些問題相當棘手。即便是兒童色情這種全球公認要審核刪除的信息,也存在模糊地帶。

2020年,Facebook成立了一個監督委員會(Oversight Board),這一委員會將獨立審理具有代表性的平台內容審核案例,決定哪些信息是違規需要刪除處理的,哪些信息又是可以公開傳播的。

這一監督委員會的成員背景多元,包括來自多個國家的法學教授和政府高官等。用戶可以直接向這個監督委員會投訴,Facebook也可以直接向委員會提交具體案件。該委員會審理的最著名的案件,莫過於特朗普賬號被封禁一案。

儘管歐美輿論對Facebook等社群媒體口誅筆伐,但這些社群媒體已經在歐美地區提供了遠優於其他地區的服務。西方的社群媒體在非洲、中東和南亞等地區雖然有大量的用戶,但並沒有實現與歐美地區同等質量的監管力度。

2021年,Facebook前數據科學家弗朗西斯·霍根(Frances Haugen),向美國證券交易委員會和《華爾街日報》披露上萬份Facebook內部文件。文件顯示,Facebook已經意識到自身在全球許多較為落後的國家沒有承擔足夠的責任。

美國以外的用戶佔Facebook總用戶數的90%以上,但負責內容治理的工作人員,只有13%的時間花在這些地區上。Facebook服務於全球160多種語言的使用者,但其僅研發了針對英語等歐美主流語言的內容審核系統,這意味著其餘很多語言的違規內容難以被系統識別和刪除。

例如在2020年底,Facebook的一份內部報告顯示,Instagram上只有6%的阿拉伯語仇恨內容能夠被系統試別;另一份報告則顯示,30天內在阿富汗發布的仇恨言論中,僅有0.23%被Facebook的系統自動刪除。

為了應對歐美政府和媒體施加的壓力,Facebook等社群媒體持續推出各項內容治理措施,但這些措施也是地區性的。Facebook內部清楚知曉自己的產品在非洲和中東等地被用於傳播極端言論、人口販賣、種族清洗等,但並沒有付出相對應的治理力度。

不過,僅憑Facebook等社群媒體自身的努力,的確也難以應對全球涉及如此之多語言、民族和宗教的問題。

技術發展給內容治理帶來了更大的挑戰。實際上,即便對有害信息存在明確的標準,即使平台有著強烈的治理決心,通過人工或技術手段甄別有害信息的難度也不低。

如今社群媒體上的許多內容,並不是真實的用戶創造發布的,而是由虛假賬號批量製造生產。這些虛假賬號又被稱為社交機器人(social bots),它們可以通過算法自動發佈內容並與其他賬號互動。這意味著,有些賬號雖然沒有散播不實信息,但因為這些賬號本身是虛假的,是被用來從事宣傳的,也需要被處理。

有研究發現,2016年美國大選第二場辯論中,Twitter上親特朗普的2400萬多條推文有三分之一由社交機器人發出,支持希拉里的72000條推文中,社交機器人生產的內容佔四分之一。

社群機器人還會隨著社交媒體上的重大事件更替,刪除其先前的推文、改變顯示用戶名後以新面目出現。儘管Twitter和Facebook大力打擊虛假賬號,但虛假賬號依然氾濫。在近來伊隆·馬斯克收購Twitter事件中,虛假賬號數量就成為了焦點之一。

在內容治理方面,社群媒體也不斷面臨新的問題。比如在虛假賬號之外,深度偽造等技術給內容治理帶來更大的挑戰。這意味著,大量的有害信息有著以假亂真的效果,並且這些有害信息的生產者不是用戶,勸阻用戶的舉措僅僅能起到減緩有害信息傳播的作用。提升內容治理水平,需要社交媒體開發更先進的技術,魔高一尺,更需道高一丈。

無法退回的昨日世界

Facebook於2004年上線,至今仍然未滿20年。在這十數年間,社群媒體讓地球村成為了現實,讓人們得以與在現實中永遠不會相識的陌生人交流。社群媒體發展初期,人們歡呼於社群媒體如何降低公共領域的表達門檻,人人都有麥克風。

但近年來,無論是關於仇恨言論、虛假信息氾濫的擔憂,還是針對信息繭房、群體極化的警惕,都體現了人們逐漸發現並試圖理解社群媒體的負面效應。內容治理已經成為社群媒體不得不直面的問題。回頭看,這場全球社群媒體的轉型運動,就始於對這種壓力的回應。

顯然,我們永遠無法退回沒有社群媒體的世界。如果未來不存在社群媒體,那也只可能是出現一種更有吸引力的替代品。如今我們只能著眼於最小化社群媒體的負面影響,探討如何在技術和產品層面改進社群媒體,如何明晰內容治理的邊界,這將是一個漫長的過程,更需要像此前高速發展期去研究用戶需求一樣,不斷改善社群媒體的功能與用戶體驗,創造更友善的社群媒體環境。或許這才是這場“轉型運動”的最大意義。(波動刻度)