蘋果MLX項目深度解析:自研AI晶片的野望

隨著人工智慧技術的飛速發展,大語言模型(LLM)在各個領域的應用越來越廣泛。然而,這些模型的運行往往依賴於強大的計算資源,特別是高性能的 GPU。蘋果公司作為科技行業的佼佼者,一直致力於推動技術創新。最近,蘋果推出了自家的 MLX 項目,旨在將先進的機器學習技術應用於其 M系列晶片上。本文將深入探討MLX項目的背景、動機、性能表現以及在實際應用中的優勢。

一、MLX 項目背景

蘋果的 M 系列晶片以其創新的統一記憶體架構(Unified Memory Architecture, UMA)而著稱,這一設計允許 CPU 和 GPU 共享同一記憶體池,從而減少了資料傳輸的需要,提高了計算效率。這種設計為機器學習任務提供了天然的優勢,因為它減少了在處理大量資料時的記憶體複製和傳輸開銷。

MLX 項目是蘋果公司為進一步提升其裝置的AI性能而啟動的一項重要計畫。隨著 M 系列晶片在 Mac和 iPad 等產品中的廣泛應用,蘋果看到了在這些晶片上整合更強大AI能力的巨大潛力。MLX 項目的目標就是開發出能夠在M系列晶片上高效運行的機器學習模型,從而為使用者提供更加流暢、智能的體驗。

二、蘋果為何自研MLX項目

蘋果選擇自研 MLX 項目,而不是直接採用開放原始碼的 PyTorch 並支援 M 晶片,背後有多重考量:

- 定製化需求:蘋果的產品設計理念強呼叫戶體驗和裝置的無縫整合。通過自研 MLX 項目,蘋果能夠根據自家產品的獨特需求定製 AI 演算法和模型,從而實現更優的性能和功耗平衡。

- 技術領先:自研項目使蘋果能夠掌握核心技術,避免依賴外部供應商。這有助於蘋果在競爭激烈的市場中保持技術領先地位。

- 生態系統整合:蘋果擁有龐大的生態系統,包括硬體、軟體和服務等多個方面。通過自研 MLX 項目,蘋果能夠更好地將這些元素整合在一起,為使用者提供更加一致和連貫的體驗。

- 使用者隱私:自主研發能夠保障資料的安全性和隱私性。在如今資料隱私備受關注的環境下,蘋果可以通過 MLX 項目更好地控制資料的處理和傳輸,確保使用者的敏感資訊得到妥善保護。

三、MLX性能表現對比

雖然目前公開的具體性能資料有限,但我們可以從一些側面資訊來推測MLX在不同M晶片上的性能表現。與輝達等傳統GPU廠商相比,蘋果的M系列晶片在能效比方面具有顯著優勢。這意味著在相同的計算任務下,M系列晶片能夠以更低的功耗實現更高的性能。

據開發人員Oliver Wehrens的測試,MLX框架在蘋果M1 Pro、M2 Ultra和M3 Max晶片上表現出色。例如,在處理OpenAI的語音識別模型Whisper時,M2 Ultra和M3 Max的處理時間分別為95秒和100秒,相較於輝達RTX 4090顯示卡的186秒,顯示出顯著的性能優勢。此外,蘋果晶片在運行狀態下的功耗也更低,這進一步證明了MLX在能效比方面的優勢。

四、將大語言模型安裝到 M 晶片裝置本地執行

為了減少大語言模型對記憶體的需求,可以採用量化的方法。量化通過降低模型參數的精度來減少記憶體佔用。然而,這種方法可能會帶來一定的負面影響,如模型精度的略微下降,或者在某些複雜場景下的表現不如未量化的模型。為瞭解決這些問題,蘋果採用了多種技術手段:

- 模型壓縮:通過剪枝、量化等技術減小模型的大小,使其能夠在有限的儲存空間內運行。

- 分佈式訓練:利用多核CPU和GPU的平行計算能力,將模型訓練任務分解為多個子任務平行處理,從而提高訓練速度。

- 記憶體管理最佳化:通過改進記憶體分配和釋放策略,減少記憶體碎片和提高記憶體利用率。

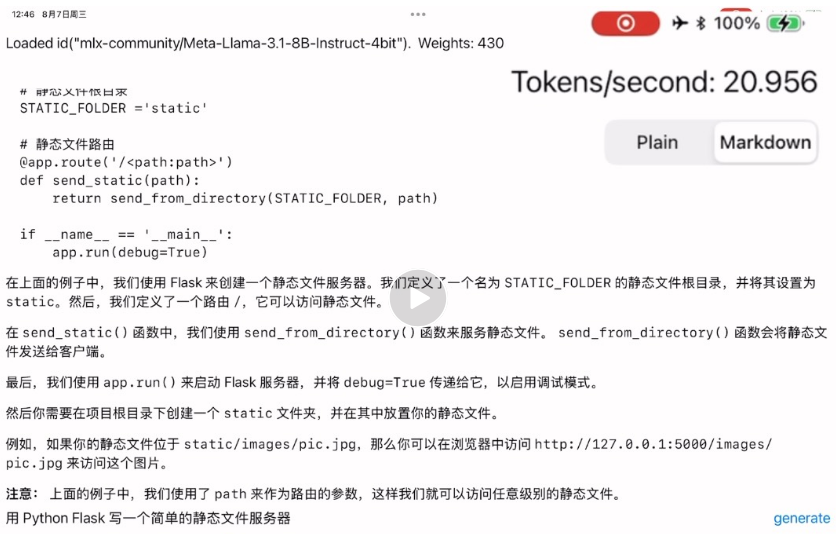

LLMEval 是一個蘋果 MLX 團隊在 GitHub 上開放原始碼的一個 Swift 示例應用程式,展示了如何下載 Hugging Face 的大語言模型(包括最新的 Meta Llama3.1、Google Gemma 等)並在 M 晶片的 iOS/iPadOS 裝置上編譯運行:

五、On-Device Apple Intelligence 的重要意義

根據蘋果最新發佈的論文《Apple Intelligence Foundation Language Models》,LLM 的 on-device 具有重要意義。On-device 意味著資料處理和模型計算直接在裝置本地進行,無需將資料上傳至雲端。這不僅能夠提供更快的響應速度,還能更好地保護使用者的隱私。

根據論文,On-Device AI(端側人工智慧)對蘋果和使用者具有以下重要意義:

- 提升使用者體驗:

- 高效支援日常任務:蘋果的基礎模型(包括AFM-on-device)被設計為能夠高效、精準地執行各種任務,以支援使用者的日常活動,例如寫作和精煉文字、優先處理和總結通知、建立有趣的圖像用於與家人和朋友的對話以及在應用內採取行動以簡化跨應用的互動等。

- 動態適應特定任務:通過使用 LoRA 介面卡,基礎模型可以針對使用者的日常活動進行微調,並且能夠根據當前任務動態地進行專業化調整,從而提升使用者在各種作業系統任務中的體驗。

- 提供高品質功能:以 AFM-on-device 模型為例,它被用於為電子郵件、消息和通知的摘要功能提供支援,通過微調 LoRA 介面卡,即使 AFM-on-device 在一般總結方面表現良好,但在嚴格符合產品團隊規定的總結要求方面存在困難時,也能提升其總結能力,從而為使用者提供更好的服務。

- 本地處理優勢:On-device AI 通過強大的裝置端處理能力和 Private Cloud Compute 等基礎設施,能夠在本地處理資料,減少了資料上傳到雲端的需求,從而降低了使用者隱私資料洩露的風險。

六、On-Device AI 的使用者體驗優勢

手機端本地運行的大語言模型對於使用者體驗具有多方面的優勢。首先,本地運行速度更快,能夠實現即時響應,減少了等待雲端資料傳輸的時間,提升了互動的流暢性。例如,OPPO Find X7 所搭載的 AndesGPT 大語言模型在端側表現出色,在內容摘要首字的生成上實現了對競品 20 倍的速度提升。

其次,本地運行有利於保護使用者隱私。資料無需上傳至雲端,降低了隱私洩露的風險。

再者,在沒有網路連線的情況下,如在飛航模式或網路訊號不佳的環境中,手機端本地運行的大語言模型仍能正常工作,為使用者提供服務。例如,Meta 和高通合作,計畫從 2024 年起讓 Llama 2 在旗艦智慧型手機上運行,其優勢之一就是在斷網情況下也能運行,為使用者提供更加私密、可靠和個性化的體驗。

此外,本地運行的大語言模型還能夠根據使用者的個性化需求進行定製,提供更貼合個人習慣和偏好的服務。例如,小米的端側大模型能夠在手機端跑通,部分場景效果可與雲端大模型媲美,並且可以實現更有效的使用者隱私保護和個性化定製。

總結

MLX 項目不僅體現了蘋果在 AI 領域的技術實力,也為開發者和研究者提供了一個強大的工具,推動了 AI 技術在更多場景下的應用和創新。隨著 MLX 的不斷髮展,我們有理由相信它將在未來的 AI 生態中扮演越來越重要的角色。 (Ai斯基)