刷屏,會騎自行車的機器人也來了

繼3月10日發佈首個具身基座模型GO-1後,3月11日上午,上海AI企業智元機器人宣佈其新款人形機器人靈犀X2上線。該企業首席技術官彭志輝稱,創業這兩年,目睹了人形機器人行業的悄然爆發。他一直的夢想是,能夠造出和人類一樣靈活和智能的機器人。

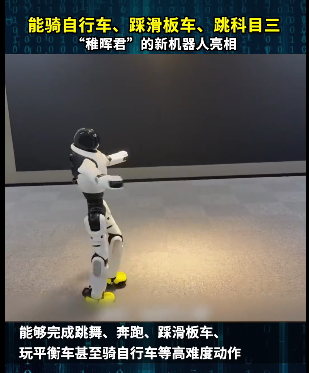

據彭志輝更新的視訊顯示,除了常規的行走、跑、跳舞外,靈犀X2還會舉重、踩滑板車、玩平衡車以及騎自行車。彭志輝稱,靈犀X2是一台具備複雜互動能力的“靈動機器人”。靈犀X2可以裝配靈巧手等末端,具備精細操作的能力。隨著機器人具身大腦的持續迭代,未來智元會賦予機器人更多複雜作業的能力。

會騎自行車的人形機器人

據彭志輝介紹,靈犀X2身高1.3米左右,他在視訊中通過與這台機器人的互動交流,展示了其互動反應,以及基於VLM的矽光動語多模態模型所賦予的通過視覺理解和認知世界的能力。

視訊中,彭志輝拿起手機問機器人“你看一下現在幾點鐘了?”X2回答道:“現在是早上5點42分。”“那我睡不著,我該喝那個飲料呢?”看到彭志輝左右手分別拿著牛奶和飲料瓶,X2回答道:“建議你喝一杯牛奶,有助於睡眠。”當彭志輝拿起一盒保健品,讓機器人幫忙看看如何使用時,X2瞄了眼包裝盒,就一字不差地把使用說明念了一遍。

彭志輝介紹,靈犀X2的本體設計中融合了大量的創新思考,比如把機器人的硬體系統抽象出了一系列可復用的核心元件,包括小腦控製器Xyber-Edge、域控製器Xyber-DCU、智能電源管理系統Xyber-BMS,以及核心關節模組Powerflow等。通過這些元件,能夠使用飛控來快速搭建起一套可靠的人形機器人系統。同時,靈犀X2使用了抗摔的柔性材料,全身擁有28個自由度,未使用任何並聯結構。

“借助當前最火熱的大語言模型技術,還為X2訓練了能定製的多模態互動大模型,所以,X2也是一台具備複雜互動能力的‘靈動機器人’。”彭志輝透露,在語音和視覺之外,他們還把動作模態也整合到了模型當中,讓X2有很多可愛的小動作,還有遠端裸眼3D交流。“我們正在完善X2的思維模型,結合矽光動語大模型,未來會賦予機器人更多情緒表達的能力。”

同時,靈犀X2採用輕量化設計,可模組化拓展,擁有完備的二次開發介面,以及預訓練模型和“采-訓-推”一站式方案,使用者可根據需求自由探索,為康養、服務、家庭陪伴等各類場景打造應用。

此前發佈首個通用具身基座大模型

3月10日,澎湃新聞記者從上海市經信委獲悉,當天上午,智元機器人正式發佈首個通用具身基座大模型——智元啟元大模型GO-1。

智元提出了Vision-Language-Latent-Action(ViLLA)架構,該架構由VLM(多模態大模型) + MoE(混合專家)組成。智元啟元大模型GO-1借助人類和多種機器人資料,讓機器人獲得了學習能力,可泛化應用到各類環境和物品中,快速適應新任務、學習新技能。同時,它還支援部署到不同的機器人本體,並在實際的使用中持續進化。

舉例來說,使用者給出指令告訴機器人要做的事情,比如“掛衣服”,模型就可以根據看到的畫面,理解這句話對應的任務要求。然後,模型根據之前訓練時看過的掛衣服流程,設想這個過程應該包括那些操作步驟,最後執行這一連串的步驟,完成整個任務的操作。

在更深層的技術層面,GO-1大模型具備了通用的場景感知和理解能力。在建構和訓練階段,該大模型學習了網際網路的大規模純文字和圖文資料,因此能夠理解“掛衣服”在此情此景下的含義和要求;學習過人類操作視訊和其他機器人的各種操作視訊,所以能知道掛衣服這件事通常包括那些環節;學習過模擬的不同衣服、不同衣櫃、不同房間,模擬過掛衣服的操作,所以能理解環節中對應的物體和環境,並打通整個任務過程;最後,因為學習過真機的示教資料,所以機器人能完成整個任務的操作。

具體來說,該款大模型的特點可以歸納為4個方面。

一是人類視訊學習:GO-1大模型可以結合網際網路視訊和真實人類示範進行學習,增強模型對人類行為的理解。

二是小樣本快速泛化:該大模型具有泛化能力,能夠在極少資料甚至零樣本下泛化到新場景、新任務,降低了具身模型的使用門檻,使得後訓練成本非常低。

三是一腦多形:該大模型是通用機器人策略模型,能夠在不同機器人形態之間遷移,快速適配到不同本體。

四是持續進化:該大模型搭配一整套資料回流系統,可以從實際執行中遇到的問題資料中持續進化學習。

智元機器人在五種不同複雜度任務上針對GO-1的測試顯示,相比已有的最優模型,GO-1的任務成功率領先,平均成功率提高了32%(46%->78%),其中在“Pour Water”(倒水)、“Table Bussing”(清理桌面)和“Restock Beverage”(補充飲料)的任務中表現尤為突出。 (南風窗)