凌晨2點,再次Open!奧特曼宣佈:OpenAI正式支援對手MCP協議

【新智元導讀】OpenAI昨夜又放大招,Agents SDK接入行業標準MCP,下一步加持ChatGPT桌面版,要徹底顛覆每個人AI工作流。

自從昨天OpenAI將GPT-4o的原生圖像生成同步開放給免費使用者後,今天他們又Open了一把。

就在剛剛,OpenAI對其Agents SDK進行了重大更新,支援了對手Anthropic推出的MCP服務協議。

凌晨2點,奧特曼便迫不及待地公佈了這個消息。

「大家都挺喜歡MCP的,我們也很興奮能在我們的產品中支援它,」Altman說。

「今天就可以在Agents SDK裡使用,ChatGPT桌面應用和Responses API也很快支援!」

OpenAI負責API的研究員Steven Heidel還在X上貼出了一張現在最火的吉卜力風格圖片,來解釋MCP的用處。

圖片展示了一個基於MCP協議的分佈式系統架構。

左邊有一個主機運行MCP客戶端(例如ChatGPT等應用),通過MCP協議與三個不同的MCP伺服器(A、B、C)通訊。

MCP伺服器A和B分別連接到本地資料來源,處理本地資料,而MCP服務C通過Web API與網際網路上的遠端服務C互動,獲取外部資料。

表明了MCP客戶端可以根據需求從不同的伺服器獲取資料或服務。

MCP持續火爆

MCP允許AI模型從業務工具、軟體、資料庫以及應用開發環境等來源中獲取資料完成任務。

可以使開發者能夠在資料來源和AI應用(如聊天機器人)之間建立雙向連接。

自從去年11月Anthropic把MCP服務協議開源後,幾個月來,很多像Block、Apollo、Replit這樣的公司都在自己的平台上支援了此協議。

到了今年2月,MCP生態進一步爆炸增長,已有超過1000個由社區建構的MCP伺服器可供使用。

而且這種網路效應會使MCP越來越有吸引力:通過MCP可用的工具越多,該標準的實用性就越大。

「很高興看到MCP的熱愛傳遞到了OpenAI——歡迎!」Anthropic的首席產品官Mike Krieger在X上發帖說。

「MCP已經成了一個蓬勃發展的開放標準,已經有幾千個整合應用,而且還在增加。只有當LLM能夠連接你現有的資料和日常使用的軟體時,它們才能發揮最大的作用。」

前段時間,霸榜開源第一的00後博士生0天復刻Manus項目OWL爆火。今天,CAMEL AI團隊創始人李國豪表示:

看到OpenAI加入MCP生態是非常激動的,有想過會有這一天,但沒有想到會這麼快。

MCP推出已有一段時間,如今它逐步成為標準,主要是因為它提供了極大的便利性,同時又是一個開放中立的協議。

MCP的意義遠遠超過了一個簡單的協議本身,而在於推動標準化的處理程序。實際上,這個協議由誰提出並不重要。

在標準缺失的情況下,各個團隊都在獨立開發自己的工具,如LangChain、LlamaIndex等,導致不同框架的Agent難以互通,不同框架的工具也難以相容。

而有了MCP,這個問題就變得簡單了。它的價值在於降低對特定框架的依賴,讓開發者只需遵循統一標準,就能自由使用各種工具。

官方SDK文件

隨著OpenAI在Agents SDK中加入對MCP的支援,開發者現在可以輕鬆地利用各種MCP伺服器,為自己的AI智能體提供豐富的工具能力。

MCP伺服器

目前,MCP規範根據傳輸機制的不同定義了兩種伺服器類型:

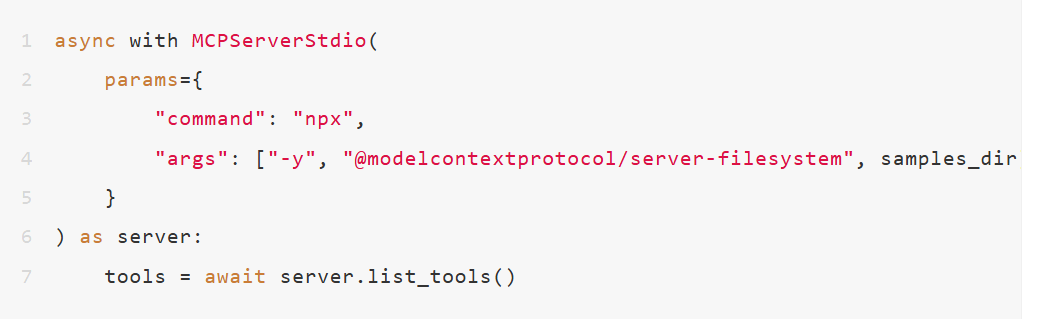

- stdio伺服器:作為應用程式的子處理程序運行,可以理解為「本地」運行的伺服器

- HTTP over SSE伺服器:遠端運行的伺服器,可以通過URL與之連接

開發者可以使用MCPServerStdio和MCPServerSse這兩個類來連接這些伺服器。

下面是一個使用官方MCP檔案系統伺服器的示例。

如何使用

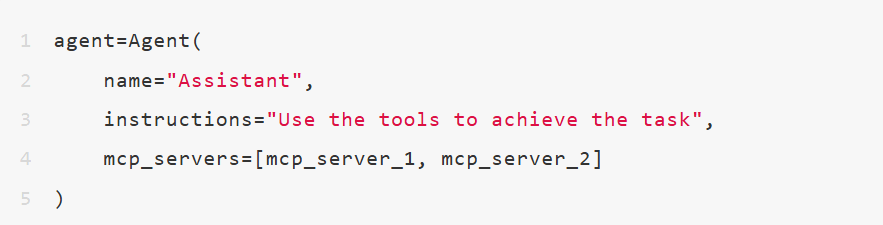

開發者可以將MCP伺服器整合到AI智能體中。

當AI智能體每次執行時,Agents SDK會自動在MCP伺服器上呼叫list_tools()函數。這一過程使LLM能夠識別並獲取MCP伺服器提供的各種工具。

當LLM需要呼叫來自MCP伺服器的某個工具時,SDK會相應地在該伺服器上執行call_tool()函數。

快取機制

每次AI智能體執行階段,系統都會呼叫MCP伺服器的list_tools()方法。這一過程可能會產生明顯的性能開銷,尤其是在使用遠端伺服器的情況下。

為了最佳化性能,開發者可以通過在MCPServerStdio和MCPServerSse建構函式中設定參數cache_tools_list=True來啟用工具列表自動快取功能。請注意:只有確信工具列表不會發生變化時,才應啟用此功能。

如需手動清除快取,可以呼叫伺服器對象的invalidate_tools_cache()方法。

鏈路追蹤

系統內建的鏈路追蹤功能能夠自動捕獲所有MCP相關操作,主要包括:

- 向MCP伺服器發起的工具列表獲取請求

- 函數呼叫過程中的所有MCP相關資訊

MCP一夜成為行業標準

MCP這一概念,還是Anthropic在去年11月首次提出,全稱為「模型上下文協議」,能夠實現一次建構,讓AI深度整合。

MCP是一個開放協議,它標準化了應用程式向LLM提供上下文的方式。你可以把MCP比作AI應用的USB-C介面——就像USB-C為裝置連接各種外設和配件提供了標準化介面一樣,MCP為AI模型連接不同的資料來源和工具提供了標准化方法。

它的本質,是為了提供一個「通用介面」,好比AI世界「萬能插頭」。

也就是所說,不同AI模型/應用能夠輕鬆連接到外部資源。這種標準化可以降低開發者的整合成本,同時提升了AI上下文感知力。

Agents SDK是前段時間,OpenAI為開發者準備的「工具箱」,用來打造自己幹活的AI智能體,比如寫郵件、整理資料。

現在這兩者一拍即合,意味著什麼?

OpenAI員工用ChatGPT繪製吉卜力風格跟蹤儀表板

開發者可用Agents SDK,直接通過MCP調取各種外部資料、工具,讓AI能夠變得更聰明、更實用。

而這僅僅是個開始,奧特曼透露的未來兩個令人期待的計畫,將進一步加速AI工作流。

如果ChatGPT客戶端也能用上MCP,就會化身為超級私人助理,去年11月每個人從Claude演示中能夠獲得關鍵一瞥。

對於開發者來說,MCP加入OpenAI API,未來可以用更少程式碼,干更多的事兒。