AMD能否跨越輝達CUDA護城河?

輝達的主導地位通常歸因於各種「護城河」——難以複製的競爭優勢。產業觀察家聲稱輝達最重要的優勢是他們的CUDA 軟體生態系統。然而,AMD、英特爾和各種新創公司等公司始終認為,無論護城河如何,他們都可以與輝達競爭。

為什麼這些公司都相信他們能夠克服CUDA 護城河?讓我們深入研究一下。

護城河的轉瞬即逝

CUDA 悠久的歷史、其產品的廣度和深度以及龐大的安裝基礎給競爭對手留下了難以克服的挑戰的印象。

然而,護城河真的無法逾越嗎?

人們普遍認為,輝達的軟體生態系統是一種持久的競爭優勢。但大多數觀察家只是指出護城河的存在或對其規模感到驚訝。

當我們理解護城河是暫時時,我們就能以不同方式思考。臨時護城河只是一個領先優勢,而軟體通常比深度技術的領先優勢更短。

讓我們探討一下影響輝達CUDA 護城河持久性的因素。

廣闊的生態系統

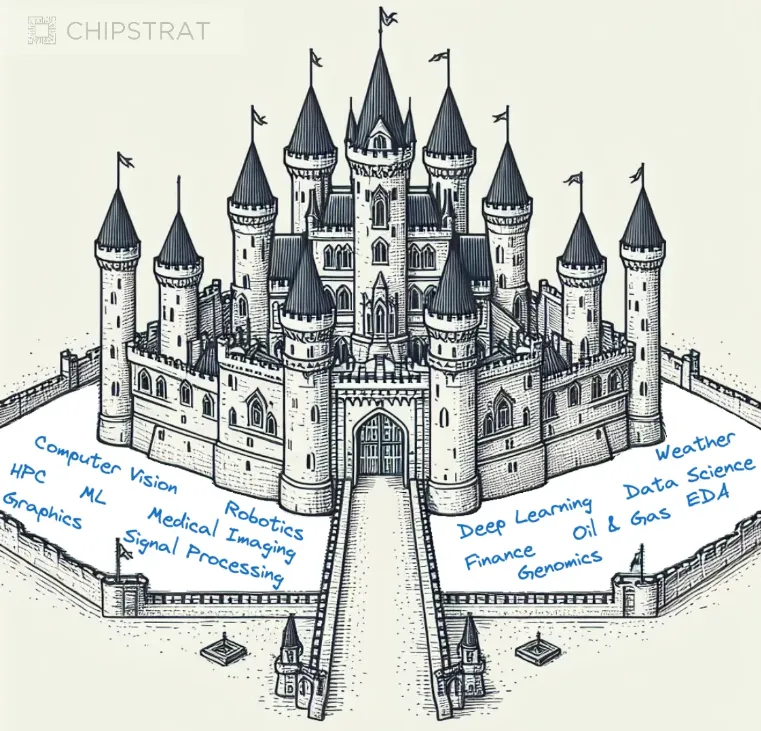

輝達提供了全面的開發工具包(包括編譯器、驅動程式和API),簡化了最佳化GPU 並行執行演算法的任務。隨著時間的推移,輝達透過針對各種領域客製化的軟體開發套件,擴大了平台的覆蓋範圍,並透過重要的核心庫和特定領域優化加深其功能。

輝達軟體生態系統的廣度和深度構成了CUDA 護城河爭論的基石,特別是透過工具擴展平台的廣度,以幫助第三方開發人員在輝達之上進行建構。

支持者認為,任何競爭對手都需要投入大量人力和財力才能趕上輝達的領先地位——畢竟,他們早在2006 年就開始了這一旅程,數量龐大的工程師一直致力於加固這條護城河。

輝達牢固地位似乎受到其CUDA 軟體生態系統的廣度和深度保護

讓我們深入探討一下,為什麼輝達建立瞭如此龐大的生態系統,競爭對手是否真的需要複製所有這些軟體來削弱輝達的護城河?

輝達軟體戰略的演變

2001年,輝達在GPU 中引進了可程式著色器,標誌著GPU 可程式性的開始。這項功能引起了學術研究人員的注意,他們認識到圖形渲染中使用的平行性類似於求解偏微分方程式等科學計算所需的平行性。

2003 年,獲得輝達獎學金的史丹佛大學博士生Ian Buck領導了Brook 流語言的開發,該語言使得在GPU 上編寫通用應用程式變得更加容易。畢業後,Ian 前往輝達,創建了統一運算設備架構(CUDA),該架構於2007年發布,開啟了輝達GPU上的通用運算時代。這些GPU 稱為通用GPU (GPGPU)。

輝達正確地採用了GPGPU 平台方法,並建立了基礎平行程式庫來支援不同領域。

當時,任何特定領域的最終價值尚不清楚。在客戶需求的推動下,輝達支援了盡可能多的領域,看看能實現什麼。這種以客戶為導向的平台策略也被稱為「把義大利麵條扔到牆上,看看黏在牆上的是什麼」。

這是正確的方法,並在許多領域釋放了先發優勢,從而產生了開發人員的慣性。

當時是CUDA平台努力的早期階段。輝達探索該平台的可能性,並尋找能夠推動大規模資料中心GPU 需求的突破性應用程式。

識別高價值領域

輝達早期的平台策略是:“每個賭注都有價值,但尚不清楚哪一個將提供顯著更高的回報”,這讓我想起了早期風險投資的動態。早期投資者押注於數十家新創公司,這些公司都有優點,希望其中一些能帶來顯著回報。

輝達的平台策略也類似。他們押注各種行業,希望能有所收穫。

許多領域都將從並行性中受益,但哪些領域會帶來巨大回報?

此時,任何像AMD 這樣的後續競爭對手,都面臨著進入艱苦戰鬥——在這個市場中輝達已經在開發商中站穩腳跟。克服輝達的先發優勢將是一項艱鉅的任務,尤其是在潛在回報不確定的情況下。這也將是昂貴的——競爭對手必須快速投入輝達在較長時期內投入成本。

顯然,效法輝達的「靠牆義大利麵」策略將是徒勞無功的。

產品與市場契合度與獲勝賭注

如果競爭對手無法與輝達的投入相匹配,他們就必須更準確地押注到最具潛力的領域。但是,選擇哪個領域?

在ChatGPT 火熱之前,選擇要押注的領域是非常困難的。對於像AMD 這樣的競爭對手來說幸運的是,已經進入了AI主導地位的第二年,獲勝的賭注突然顯而易見。

深度學習是我們一直在等待的變革領域,而產生人工智慧是廣泛的用例,具有消費者規模採用的明確路徑。

潛力領域的預期值如下所示:

深度學習是第一個提供巨額回報的領域

在接下來的十年中,支援深度學習的生成式人工智慧,對硬體產業的預期價值比其他高效能運算領域高出幾個數量級。這個領域將催生更顯著的晶片數量需求。

突破輝達護城河

到目前為止,輝達的軟體護城河似乎十分堅固,擁有巨大的領先優勢和先發優勢。

像AMD 這樣的競爭對手和包括MatX在內的各種新創公司,現在知道在哪個領域押寶下注——全力押註生成式人工智慧。

競爭對手透過讓他們的硬體盡可能快速/便宜/節能地運行基於深度學習的生成式人工智慧模型、「比GPU 好10-100 倍」的價值主張來吸引輝達的客戶。他們將全力編寫支援GenAI 用例所需程式碼,讓開發人員盡可能輕鬆地進行轉換。

AMD 的未來之路

現在,生成式AI 已成為明顯的投資領域,AMD 的地位比一兩年前要有利得多。但還沒有脫離困境。

與CUDA 一樣,ROCm 是AI 應用程式的理想解決方案,一些深度學習框架已經支援ROCm 後端(例如TensorFlow、PyTorch、MXNet、ONNX、CuPy 等)。 AMD 表示,任何CPU/GPU 供應商都可以利用ROCm,因為它不是專有技術。

這意味著用CUDA 或其他平台編寫的程式碼可以移植為供應商中立的HIP 格式,使用者可以從那裡為ROCm 平台編譯程式碼。

但ROCm 在開發者中的影響力要弱於CUDA,輝達除了擁有領先優勢外,每年還幾乎投資數十億美元用於CUDA的開發和生態系統擴展

另外,AMD ROCm 平台是開源的,這意味著任何人都可免費使用和修改,開發人員更容易為ROCm 平台開發應用程式和工具,也讓ROCm 平台更具可擴充性和靈活性。

但AMD 始終要解決缺乏知名度和生態系統不完善等關鍵問題,另外還必須在ROCm文件、效能和相容性方面加倍努力。儘管AMD設想的開放生態系統非常引人注目,但要使其成為現實仍需極大的關注。

這場戰鬥還遠遠沒有結束。(潮觀世界)