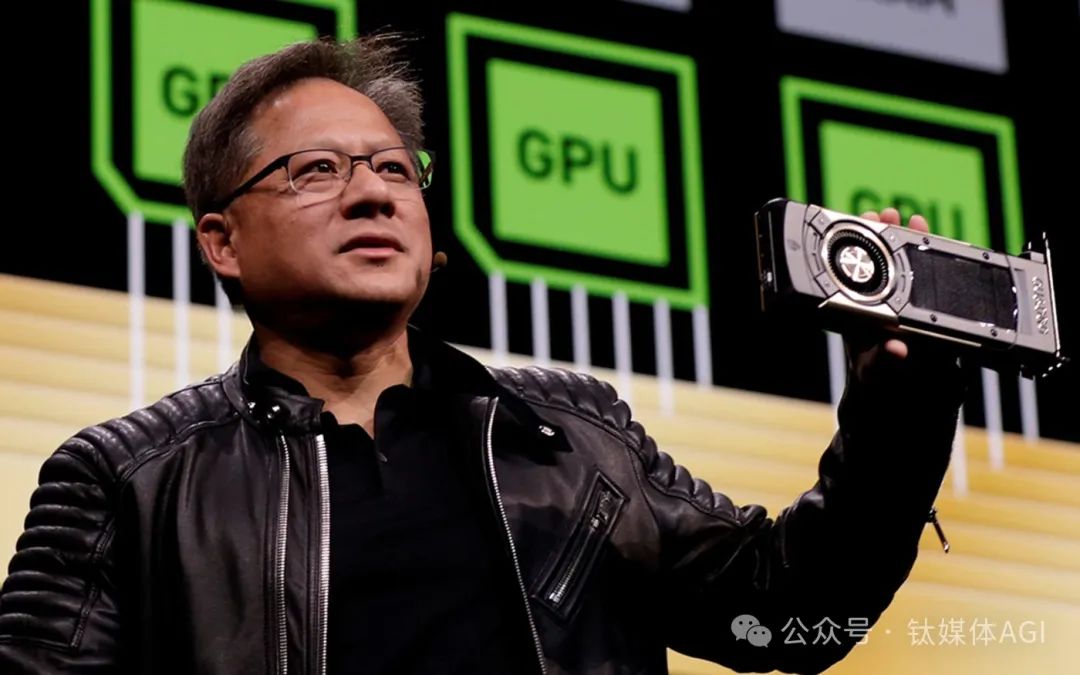

黃仁勳丟重磅“核彈”,全新輝達RTX 500顯卡AIGC性能提升高達1400%,AI PC時代真要來了

台北時間2月26日,市值2兆美元的AI 晶片巨頭輝達(NVIDIA)宣布推出全新NVIDIA RTX 500 和1000 Ada一代消費級GPU(圖形處理器)加速晶片,全面支持在輕薄筆記型電腦等行動裝置中運行生成式AI(AIGC)軟體。

輝達表示,與僅使用CPU的配置相比,全新RTX 500 GPU可為Stable Diffusion等模型提供高達14倍(1400%)的AIGC效能,AI 照片編輯的速度提高3倍,3D渲染性能提高10倍,從而全面提升生產力效率。

作為入門款GPU產品,輝達RTX 500將成為全球內建AIGC技術且價格最便宜的GPU晶片。

同時,這也意味著,黃仁勳持續降低AI PC設備門檻,即將大量出貨輝達GPU晶片,消費者「買筆電送AI 」的時代真的要來了!

據悉,輝達RTX 500和RTX 1000均採用與RTX 4090、L40伺服器GPU一樣的Ada Lovelace架構,或採用台積電4N(5nm)工藝,擁有神經處理單元(NPU)、第三代RT 核心、第四代Tensor Core、Ada一代CUDA核心、專用GPU記憶體、DLSS 3光線追蹤技術、第八代NVIDIA AV1(NVENC)編碼器等一系列旗艦AI 晶片才擁有的重要配置。

輝達稱,隨著AIGC和混合工作環境成為新標準,無論是內容創作者、研究人員還是工程師,幾乎每位專業人士都需要一台強大AI 加速功能的筆記型電腦來幫助使用者應對產業挑戰。而RTX 500 和1000 GPU 透過AI 為各地緊湊型設計的筆記型電腦使用者提升工作流程。

具體來說,首先,基於NVIDIA Ada Lovelace 架構,RTX 500 和1000 GPU晶片擁有第三代RT 核心,光線追蹤效能比上一代提升了2倍,可實現高保真、逼真的渲染。

其次,搭載第四代Tensor Core AI 加速技術下,RTX 500 和1000 GPU吞吐量是上一代的2 倍,可應用於深度學習訓練、推理和基於AI 的創意工作負載。

再次,與上一代相比,擁有最新CUDA核心的RTX 500 和1000 GPU,單精度浮點(FP32) 吞吐量提高30%;而第八代NVIDIA 編碼器支援AV1,效率比H.264 高出40 %。

最後,RTX 500 GPU 配備4GB GPU專用內存,RTX 1000 GPU 配備6GB GPU專用內存,可處理更大的項目、資料集和多應用工作流程,全面支援部分複雜3D場景和AI 應用研發。

另外,內建NPU的RTX 500 和1000 GPU晶片,可提供最高193 TOPS 的AI 效能,滿足日常AI 工作流程。如果你希望利用AI 來實現深度學習、資料科學、進階渲染等工作流程,輝達也提供RTX 2000、3000、3500、4000 和5000 Ada筆記型電腦GPU,最高支援682 TOPS 的AI 效能。

很顯然,黃院士的想法是:一旦要用AI,就要買輝達GPU顯示卡。沒有更高效能的CPU難以開發和使用AIGC 應用程式。

「你買的越多,你省的就越多。」黃仁勳曾說。(The more You buy,the more You save )

輝達透露,全新NVIDIA RTX 500 和1000 Ada 世代筆記型電腦GPU 將於今年春天在戴爾、惠普、聯想和MSI 等行動工作設備中應用。

實際上,在AI 時代下,鈦媒體App編輯手中的一台Redmi Book 15E,由於沒有內置NVIDIA獨立顯卡,因此,我們安裝很多支持CUDA如NVIDIA App等多款AI 應用就會顯示“安裝無法繼續” ——很顯然,GPU已深深改變了我們的生活。

近期公佈的輝達最新財報顯示,2024財年,輝達收609.22億美元,年增126%;淨利年增581%,至297.60億美元,成為地表最強的公司。

受利多業績影響,輝達美股持續大漲。

2023年,輝達股價已累計上漲236%,進入2024年英輝達價短短兩個月漲幅又超過63.05%,最新市值約2兆美元。

如今,在新的AI 時代下,全球科技巨頭排行發生了重大變化:輝達超越了谷歌、亞馬遜等一眾巨頭,已成為全球第三大科技公司,僅次於微軟、蘋果。

隨著股價暴漲,輝達聯合創辦人兼CEO黃仁勳身價也水漲船高,最新增加85億美元,至681 億美元,成為全球第21位最富有的人。

黃仁勳不僅超越科氏工業CEO查爾斯‧科赫(Charles Koch),也成功超越中國首富、農夫山泉創辦人兼董事長鐘睒睒。

對於中國市場,輝達也首次提到,華為是輝達重要的競爭對手之一。同時,黃仁勳對外確認,輝達向客戶提供A100/H800 AI 晶片的替代樣品,同時遵守了美國商務部半導體出口管制規定。

黃仁勳最近接受《Wired》對話時坦言,華為是非常好的公司。儘管他們受到現有半導體處理技術的限制,但他們仍然可以透過將許多晶片聚集在一起來建立非常強大的系統。

黃仁勳強調,輝達非常期望去中國市場進行業務競爭,並希望「我們能夠成功地服務市場」。

2月26日晚,美國儲存晶片巨頭美光科技(Micron Technology)宣布,該公司已開始大量生產其用於AI加速的先進Micron 24GB HBM3E內存方案,提供高達1.2 TB/s頻寬,相比競爭對手功耗降低30%,應用於輝達H200 Tensor Core GPU,最快將於2024年第二季出貨。

隨著輝達A100、H100晶片的成功量產,輝達瞄向AI 超算雲Nvidia DGX Cloud、AI 軟體棧Nvidia AI Enterprise等全新業務。

黃仁勳先前表示,生成式AI 讓每個(軟體)企業都擁抱加速運算,提高吞吐量,而輝達將利用Nvidia AI Enterprise,對這些企業所有的軟體堆疊進行管理、優化、修補。而Google成為了Nvidia AI Enterprise的最新合作方。

「我們將其推向市場的方式是將Nvidia AI Enterprise 視為作業系統,每年每個GPU 收取4500 美元。我的猜測是,世界上每一家在專有雲和私有雲中部署軟體的軟體企業公司,都將在Nvidia AI Enterprise 上運行。」黃仁勳表示。

半導體行業機構Futurum Research 首席執行官丹尼爾·紐曼(Daniel Newman) 認為,“英特爾曾經是業界的霸主。而現在,很多公司正聯合起來,以確保輝達不會變得太強大。”

綜合多方消息,3月18日舉行的GTC大會上,輝達將推出基於下一代Blackwell GPU架構的新款B100 AI晶片,採用台積電3nm製程製程、三星提供最新HBM儲存技術,據推測B100效能至少是H200的兩倍、也就是H100的整整四倍,預計B100將成為全球最強大的AI 晶片。(鈦媒體)