黃仁勳:輝達下一代Rubin架構AI晶片將於2026年推出,全球AI產業規模或高達100兆美金

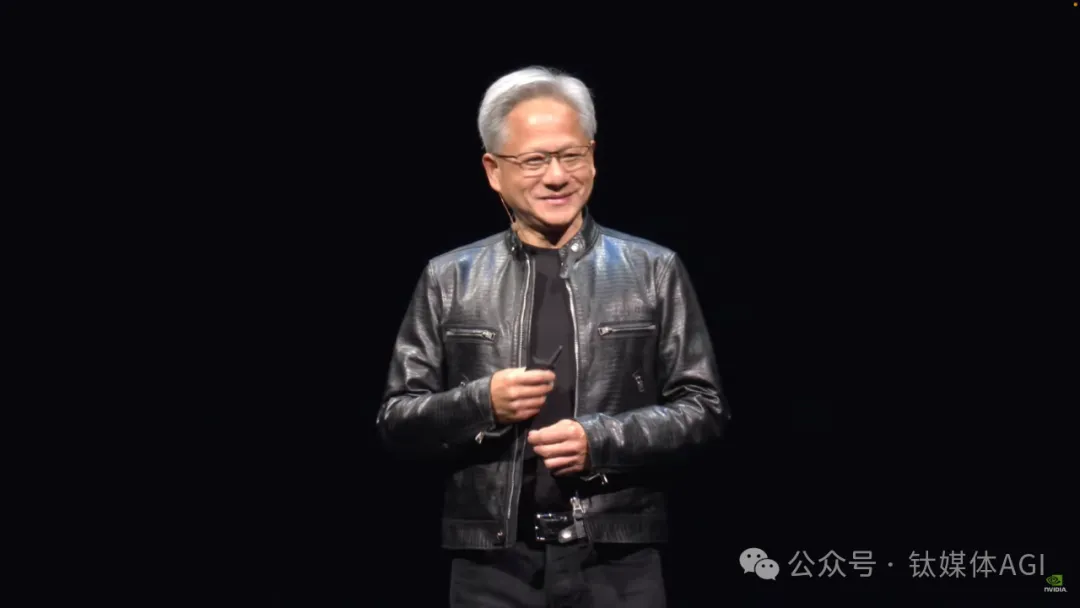

就在剛剛,身價961億美元(約6,959.56億元)的老黃,在台北超過5,000人的體育場內,全面展示AI 「核彈」帶來的新產業革命。

6月2日晚,「AI教父」、輝達創辦人、CEO黃仁勳(Jensen Huang)宣布,輝達打算每年都升級AI加速器/AI晶片,去年發布的Blackwell晶片現在開始投產,2025年將推出Blackwell Ultra,而下一代AI 晶片架構平台名為Rubin,採用HBM4晶片,預計於2026年推出。

同時,黃仁勳也宣布推出推理模型微服務NVIDIA NIM,以部署在雲端、資料中心或工作站上,並且開發者能夠輕鬆地為Copilot、ChatGPT等建立生成式AI 應用,所需時間從數周縮短至幾分鐘。另外,輝達則針對GeForce RTX AI電腦平台推出AI助理,為數位人推出G-Assist和NVIDIA ACE(數位人技術) NIMs,以及為微軟Windows Copilot Runtime推出用於RTX加速API的小語言模型(SLM)等等。

黃仁勳全程演講接近2小時,廣達董事長林百里、和碩董事長童子賢等台系供應鏈廠商高管均悉數到場,現場5000多人座無虛席,而黃仁勳攜帶無數款輝達新產品,希望讓產業鍊和更多人看到新的AI 時代下,輝達處於GPU和AI 技術的「交匯點」。

「今天,我們正處於運算領域重大轉變的風口浪尖。AI 和加速運算的交匯將重新定義未來。」黃仁勳強調,未來,全球AI產業規模將高達100萬億美金,比之前IT時代的3萬億美元高出33萬倍以上,具有強大的市場前景。

黃仁勳引領的新一輪以AI 為核心的產業革命已經開始。

從CUDA軟體到GPU硬件,輝達正“加速一切”

這次COMPUTEX上黃仁勳的演講內容,鈦媒體AGI梳理成四大主題層面:NIM軟體,晶片架構和硬件,Omniverse和NVIDIA ACE,以及機器人技術。

首先,黃仁勳表示,電腦產業迎來了非常令人興奮的時刻,整個產業將被改變。而加速運算、和在全宇宙中運行的AI 這兩種技術力量將重塑電腦產業。其中,CPU處理效能擴展已大大放緩,「摩爾定律」已經跟不上AI 數據和運算能力的發展,而基於GPU的加速運算和CUDA系統將「加速」電腦的應用研發速度。

「我們正在看到世界各地使用的數據中心電力數量正在大幅增長,計算成本正在增長,而且看到了計算通貨膨脹。當然,這不能再繼續下去了。同時,數據將繼續呈指數級增長,CPU性能擴展將永遠不會恢復到之前狀態。的。

黃仁勳表示,「GPU處理器可以降低能耗和運算時間,並且運算速度之快令人難以置信。例如,如果GPU可加快100倍的運算速度,但你只增加了大約三倍的功率、只增加大約50%的成本。力工廠。

黃仁勳強調,8年內輝達AI 運算架構加速了1000倍。

「加速運算是永續運算,」他稱,GPU和CPU的組合能夠實現高達100倍的加速,同時僅將功耗增加三倍,與單獨使用CPU 相比,每瓦效能提高了25 倍。

輝達也展示了基於加速運算技術的模式如何更快、更省錢的預測天氣。基於NVIDIA Earth-2研發的天氣類生成式AI 模型CorrDiff,可以將25 公里模型解析為2 公里,速度提高了1,000 倍,單次推理所消耗的能量比傳統方法減少了3,000 倍,同時成本削減50倍,能源消耗削減25 倍,以實現更快、更準的預測天氣和氣候變遷。

輝達稱,這意味著,過去需要近300 萬美元才能完成一組CPU 及其運作所需的能源的工作,現在只需使用NVIDIA H100 Tensor Core GPU 的單一系統,僅需約6 萬美元即可完成。這是一個巨大的節省,顯示生成式AI 和加速運算如何提高能源效率並降低總體擁有成本(TCO)。

黃仁勳指出:“買得(GPU)越多,省得(功耗和成本/TCO)越多”,強調了這種方法可以顯著節省成本和能源。

隨後,黃仁勳一再強調CUDA軟體系統生態對於AI 時代的重要性。目前,輝達全球擁有500萬開發者在CUDA生態上進行開發,服務包括醫療保健、金融服務、電腦、汽車等各行各業,幾乎每一個科學領域因為有CUDA生態架構才可以獲得使用者。

因此,黃仁勳重磅推出首個基於GPU雲端的生成式AI 推理部署服務:NVIDIA NIM,透過優化容器形式提供模型,部署在雲端、資料中心或工作站上。透過NVIDIA NIM,開發者能夠輕鬆地為Copilots、聊天機器人等建立生成式AI 應用,所需時間從數周縮短至幾分鐘,目前包括40餘個NIM微服務為跨模式的生成式AI 賦能。

具體來說,NVIDIA NIM 提供了一種簡單、標準化的方式,將多個模型來產生文字、圖像、視訊、語音等生成式AI 添加到應用程式中,顯著提高了開發者的工作效率。包括Cadence、Cloudera、Cohesity、DataStax、NetApp、Scale AI 和新思科技等近200 家技術合作夥伴正在將NIM 整合到他們的平台中,以加快特定領域應用的生成式AI 部署。

黃仁勳表示,「每個企業都希望在其營運中融入生成式AI,但並非每個企業都擁有專門的AI 研究團隊。NVIDIA NIM 可被整合到任意平台中,任何地方的開發者都可以訪問,並且可以在任意環境中運行——它正在助力科技行業將生成式AI 普及到每一個企業組織。

另外,輝達今日也宣布,整合NVIDIA Holoscan的NVIDIA AI Enterprise-IGX 軟體現已在NVIDIA IGX 平台上正式可用,以滿足工業邊緣對即時AI 運算日益增長的需求。它們將共同幫助醫療、工業和科學計算領域的解決方案提供商利用企業級軟體和支援來加快開發和部署邊緣AI 解決方案。

其次,黃仁勳首次透露下一代技術架構:Rubin。

黃仁勳透露,輝達新的GPU架構將從兩年一次迭代,加速到以一年為周期推出。而Rubin 平台首次亮相,將取代即將推出的Blackwell 平台,該平台具有新的GPU、新的基於Arm 的CPU — Vera — 以及具有NVLink 6、CX9 SuperNIC 和X1600 融合InfiniBand/乙太網路交換器的高級網路。

「我們公司有一年的節奏。我們的基本理念很簡單:建立整個資料中心規模,然後以一年的節奏拆解並出售給您,並將一切推向技術極限,」黃仁勳解釋。

同時,我們在圖中也看到Vera CPU-下一代ARM CPU架構,他們共同出現在新的Vera Rubin加速器上。而這個名稱來源,其實是來自美國一位女性天文學家Vera Rubin——研究暗物質先驅。

另外,在網路方面,黃仁勳公佈每年發布Spectrum-X 產品的計劃,以滿足AI 對高效能乙太網路日益增長的需求。此次發表的全新NVIDIA Spectrum-X,是首款專為AI 打造的乙太網路架構,與傳統乙太網路架構相比,其網路效能提高了1.6 倍。它可加速AI 工作負載的處理、分析和執行,進而加速AI 解決方案的開發和部署。

據悉,CoreWeave、GMO Internet Group、Lambda、Scaleway、STPX Global 和Yotta 是首批採用Spectrum-X 的AI 雲端服務供應商,旨在為其AI 基礎設施帶來極致的網路效能。

基於GPU的強大加速運算能力,黃仁勳也宣布永擎電子、華碩、技嘉、鴻佰科技、英業達、和碩、QCT、Supermicro、緯創業通和緯穎將使用NVIDIA GPU 和網路打造雲端、專用系統、嵌入式和邊緣AI 系統,從單GPU 到多GPU、從x86 到Grace、從風冷到液冷等全面進行整合輝達“全家桶”,豐富的產品組合覆蓋雲、專用系統、嵌入式和邊緣AI 系統等。

「新一輪工業革命已經開始。許多企業和地區正在與NVIDIA 合作推動價值萬億美元的傳統數據中心向加速計算轉型,並建造一種新型數據中心——AI工廠來生產新的商品'人工智能'。

再次,黃仁勳重點談及NVIDIA ACE數位人類AI 技術,以及Omniverse數位孿生技術。

輝達發布的數位人AI 微服務NVIDIA ACE(Avatar Cloud Engine),可以讓遊戲NPC具有AI對話功能,同時能直接產生數位人的語音和臉部動畫,從而以加速下一波數位人類的誕生,提升遊戲和虛擬角色互動體驗的技術,以及即將在該平台上實現的全新生成式AI 突破。

目前,客戶服務、遊戲和醫療保健領域的公司率先採用ACE 技術,簡化客戶服務、遠距醫療、遊戲和娛樂領域逼真的數位人類的創建、動畫和操作。而NVIDIA ACE技術套件包括NVIDIA Riva ASR、TTS和NMT、NVIDIA Nemotron LLM、NVIDIA Audio2Face、NVIDIA Nemotron-3 4.5B — 一種新型小型語言模型(SLM),專為低延遲、設備上RTX AI PC 推理而構建等。

同時,輝達已將ACE 作為NIM 微服務提供給開發人員在資料中心運作。現在,NVIDIA 正在建置ACE PC NIM 微服務,以部署在1 億台RTX AI PC 和筆記型電腦上。

另外,關於輝達Omniverse,黃仁勳稱,NVIDIA Metropolis視覺AI、 NVIDIA Omniverse基於物理的渲染和模擬以及NVIDIA IsaacAI 機器人開發和部署,助力台達電子、富士康、和碩、緯創以數字化方式構建、模擬和運營工廠數位孿生。

富士康(鴻海)有透露,其在墨西哥的工廠採用了輝達的一系列自動化和數位化技術,基於目前的努力,該公司預計可以使用模擬工廠提高複雜伺服器的製造效率,從而大幅節省成本並每年減少30% 以上的千瓦時使用量。

富士康執行長兼董事長劉揚偉表示:「AI和機器人技術有望徹底改變製造業,提高工廠車間的安全性並顯著提高營運效率。透過將NVIDIA Omniverse、Metropolis 和Isaac 整合到我們的營運中,我們可以創建工廠的複雜數位孿生來訓練機器人,以前所未有的精度優化工作流程並降低成本。

輝達強調,公司正引領價值50 兆美元的工業數位轉型,各產業都採用自主營運和數位孿生——提高效率和降低成本營運工廠。

針對消費性設備,黃仁勳透露,目前有超過200款RTX AI 筆記型電腦上市,整個性能高達700 AI TOPs。

最後是機器人。

「下一波人工智慧是物理人工智慧。能夠理解物理定律的人工智慧,能夠在我們之中工作的人工智慧,」黃仁勳強調了機器人和AI 在未來發展中的重要性。

輝達發布的NVIDIA Isaac 平台,為開發人員提供了強大的工具包,以建造AI 機器人,包括AMR、工業機器手臂和人形機器人,由AI 模型和Jetson Orin 和Thor 等超級電腦提供支援。

「機器人技術已經到來。實體人工智慧已經到來。這不是科幻小說,它正在台灣各地使用。這真的非常令人興奮,」黃仁勳稱,全球電子巨頭正在將NVIDIA 的自主機器人整合到他們的工廠中,包括全球超過500 萬個預編程機器人正在進入工廠。

「未來,所有工廠都將是機器人工廠。工廠將協調機器人,而這些機器人將製造機器人產品,」黃仁勳說。

目前,比亞迪電子、西門子、泰瑞達和Alphabet 旗下公司Intrinsic 等全球十多家機器人行業領先企業,正在將NVIDIA Isaac 加速庫、基於物理學的模擬和AI 模型整合到其軟體框架和機器人模型中,以此提高工廠、倉庫和配送中心的工作效率,使機器人的人類同事更安全地工作,並使機器人成為執行重複性或超精密任務的智慧助理。

同時,100 多家公司正在採用Isaac Sim 來模擬、測試和驗證機器人應用,其中包括海克斯康、富世華和MathWorks。 Agility、波士頓動力公司、Figure AI、傅利葉智慧和Sanctuary AI 正在使用Isaac Lab。

黃仁勳強調,未來所有的產品都將是機器人,當然,其中之一是自動駕駛汽車,或具有大量自主能力的汽車。

「下一個大批量機器人產品將由機器人工廠製造,內部有機器人,可能是人形機器人。近年來,這在基礎模型的認知的能力和正在發展的世界理解能力方面都有很大進步。我對這個領域感到非常興奮,因為很明顯,最容易適應世界的機器人是人類或機器人,'我們'(人形機器人)為我們建造世界。 。

總結來說,黃仁勳這次從CUDA軟體到GPU硬體全面更新,證明輝達正“加速一切”,以鞏固其在AI 算力領域的領先地位。

黃仁勳霸氣盡顯,輝達要統領全球AI生態

目前,輝達已成為AI 領域的重要推動者,規模超過2兆美元,僅次於蘋果。

就在5月22日美股盤後,輝達發布的2025財年第一季財報(2024自然年第一季)顯示,當季實現營收260億美元,年比大增262%,季增18%,再創單季營收歷史新高;淨利148.81億美元,季增21%,年增628%,營收獲利雙雙暴增。

輝達預計,今年第二財季營收為280億美元,上下浮動2%;非通用會計師準則下毛利率約75.5%,上下浮動50個基點。這項營收指引高於彭博統計的266億美元市場預期。

這樣一種營收預期,讓黃仁勳樂到開花。因此,為了這次演講,黃仁勳提早一個星期來到台北,逛夜市、請酒會、接受人們拍照採訪,甚至和台系供應鏈成了「鐵哥們」。

有趣的是,在發表會前夕的一場酒會上,黃仁勳宴請台系供應鏈廠商高層-華碩董事長施崇棠、和碩董事長童子賢、鴻海董事長劉揚偉、緯創總經理林建勳、緯穎董事長洪麗寧、廣達董事長林百里、雲達(廣達旗下伺服器代工廠)總經理楊麒令、英業達董事長葉力誠、英業達總經理蔡枝安、台達電董事長鄭平、宜鼎董事長簡川勝、廣運董事長謝清福及CEO謝明凱等10餘人,參與者的身價共計1.5兆元人民幣,每桌消費約1040元。而且,黃仁勳還請台積電創辦人張忠謀一起逛夜市,引發所有人的關注。

黃仁勳在餐敘的一開始,便霸氣站在椅子上致詞,他指出,「我們正在進入AI的新一代,你們生產的東西,是世界上最有價值的產品,這個AI世界若是沒有你們的產品,就不可能產生。

現場立刻有人附和,“我們enjoy”,而黃仁勳也回應“我也enjoy”。

「AI對台灣IT產業來說將會是很龐大的商機,台灣仍會維持全球科技產業中心的重要地位。台灣是AI科技的中心,我與台灣的朋友及CEO們相聚在一起,也為這個新時代做準備,科技的擴張將使得台灣受益,因為台灣佔據了中心地位。

而且,黃仁勳還與張忠謀把酒言歡。

根據Digitimes Research先前發表的2022年數據顯示,在全球伺服器代工製造市場,鴻海的份額高達43%,穩居第一,其除了為惠普(HP)及戴爾(DELL)等品牌代工之外,還握有亞馬遜和微軟資料中心的訂單。緊接而來的廣達、緯創、英業達的市佔率分別為17%、14%、12.8%、7.6%。之後除了美商美超微(Supermicro,美國超微電腦股份有限公司)之外,還有神達、技嘉、環鴻、仁寶、和碩,基本上都是台系廠商。

整體來看,在全球的伺服器代工市場,台系廠商則佔據了全球約90%的市場。

此次,黃仁勳演講結束後,接下來幾天內,Computex大會還會迎來AMD CEO蘇姿丰、英特爾CEO基辛格等8大AI 廠商代表演講。

- 6 月3 日(9:30-11:00):AMD 蘇姿丰

- 6 月3 日(13:30-14:40)高通克里斯蒂亞諾・阿蒙

- 6 月4 日(11:00-12:00)英特爾帕特・基辛格

- 6 月4 日(13:30-14:30)聯發科蔡力行

- 6 月5 日(09:30-10:30) 超威電腦梁見後

- 6 月5 日(13:30-14:30)恩智浦Lars Reger

- 6 月6 日(11:00-12:00) 台達闕志克

(鈦媒體AGI)